引言

生产与数据采集集成软件项目在现代工业中扮演着关键角色,它能够实现生产流程的自动化监控与数据的高效采集,从而优化决策并提升效率。然而,从零开始搭建这样的系统并非易事,涉及复杂的规划、技术选型、开发与测试流程。面对数据来源多样、系统稳定性要求高以及实时性需求等挑战,企业需要一套清晰的实施路径。本文将详细拆解从项目规划到部署上线的完整步骤,帮助团队高效完成系统搭建。

一、项目规划与需求分析

1、明确项目目标和范围

生产与数据采集集成软件的核心目标是实现工业现场数据的自动化采集、实时传输与集中管理。项目范围需涵盖设备层数据接口协议适配、边缘计算节点部署、云端数据仓库构建三个层级。例如,某汽车零部件工厂通过界定采集5类PLC设备的200+传感器数据,将项目边界控制在冲压车间数字化改造范围内,避免范围蔓延风险。

2、分析业务流程和数据采集需求

采用“逆向工程”思维,从最终报表需求反推数据采集点。需梳理产线OEE(设备综合效率)计算涉及的停机事件分类、工艺参数阈值等业务规则。某光伏电池片项目案例显示,明确每15秒采集一次温度曲线数据的需求,直接影响后续时序数据库选型。

3、确定技术栈和工具选择

工业场景优先考虑OPC UA协议栈与MQTT传输的组合方案。对于中小型项目,采用Node-RED进行逻辑编排搭配InfluxDB时序数据库,可降低60%的编码工作量。当涉及高并发采集时,Apache Kafka的消息队列架构能有效解决数据峰值冲击问题,某注塑机监控项目实测单节点支持8000+数据点/秒的稳定采集。

二、系统设计与架构搭建

1、设计数据采集与处理流程

数据采集流程需遵循高时效性与低侵入性原则。采用分布式采集节点设计,通过Kafka或RabbitMQ实现异步消息队列,确保每秒万级数据的吞吐能力。对于工业传感器数据,需设计协议转换层(如OPC UA转MQTT),兼容Modbus、CAN总线等常见工业协议。数据处理环节引入流式计算框架(如Apache Flink),实时完成数据清洗、归一化和异常检测,延迟控制在50毫秒以内。

2、构建系统架构和模块划分

采用微服务架构划分核心模块:

- 采集代理层:负责设备连接与协议适配,支持动态加载驱动

- 流处理引擎:部署规则引擎(如Drools)实现实时业务逻辑

- 存储服务:时序数据库(InfluxDB)存储原始数据,关系型数据库(PostgreSQL)管理元数据

- API网关:统一鉴权与限流,提供RESTful和WebSocket双通道

架构设计中特别强调松耦合,各模块通过gRPC进行通信,服务发现采用Consul实现。对于高并发场景,在采集端部署边缘计算节点,先行过滤无效数据。

3、数据库设计与优化

时序数据采用分级存储策略:

- 热数据:保留30天,使用SSD存储

- 温数据:保留1年,采用压缩列存储

- 冷数据:归档至对象存储

建立复合索引时遵循5W1H原则(When,Where,Who,What,Why,How),对时间戳、设备ID、数据标签建立联合索引。针对高频查询,使用物化视图预计算指标,查询响应时间优化至200ms以下。定期执行统计信息更新和索引重建,避免数据碎片化影响性能。

三、开发与集成

1、数据采集模块开发

数据采集模块是集成软件的核心组件,需支持多源异构数据接入。采用模块化设计原则,针对传感器、数据库、API等不同数据源开发独立适配器。例如,工业设备数据通过OPC UA协议实时采集,Web数据采用Scrapy框架爬取,确保采集频率与业务需求匹配。关键点在于异常处理机制的设计——当网络中断或数据格式异常时,自动触发重试逻辑并记录错误日志,避免数据丢失。同时,通过数据缓冲池技术平衡采集峰值压力,提升系统稳定性。

2、数据处理与分析模块开发

原始数据需经清洗、转换、聚合三层处理。清洗阶段采用规则引擎剔除重复值和异常值,如设定阈值过滤传感器漂移数据;转换阶段通过ETL工具将非结构化日志转为JSON格式;聚合阶段按时间窗口统计关键指标,如设备OEE(全局设备效率)。实时分析采用流式计算框架(如Apache Flink),离线分析依托分布式存储(如HDFS)。模块需内置机器学习接口,为预测性维护等场景预留算法集成空间。

3、系统集成与API对接

通过RESTful API实现跨系统数据互通,遵循OpenAPI规范生成交互文档。对于高实时性场景,采用WebSocket协议推送数据变更事件。集成测试需覆盖:

- 身份认证(OAuth2.0/JWT令牌验证)

- 流量控制(令牌桶算法限流)

- 数据一致性(分布式事务补偿机制)

与企业现有MES/ERP系统对接时,需定制中间件处理数据格式转换,如将工单数据从XML映射到关系型数据库字段。使用Postman进行接口自动化测试,确保不同负载下的响应时间达标。

四、测试与优化

1、功能测试与性能测试

功能测试需覆盖所有数据采集模块、处理逻辑及集成接口,采用黑盒与白盒测试结合的方式验证输入输出准确性。例如,模拟高并发数据流检测采集模块的稳定性,或通过边界值分析法验证数据处理规则的容错性。性能测试则聚焦系统负载能力,使用工具模拟千人级实时数据写入,监测响应时间、内存占用等关键指标,确保在峰值压力下仍能维持90%以上的API成功率。

2、系统优化与调整

根据测试结果,针对瓶颈环节实施定向优化。数据库层面可采用索引重构或查询语句重写,将慢查询耗时降低50%以上;代码层级通过异步处理非关键任务,减少主线程阻塞。曾有一家制造企业通过压缩数据传输频次,将服务器资源消耗优化了37%,同时保持数据采集实时性。优化过程中需建立基线指标,每次调整后对比数据变化。

3、用户验收测试

组织业务部门参与场景化测试,验证系统是否匹配实际生产需求。设计涵盖设备异常、网络中断等20+异常用例,确保系统能自动触发预设容灾机制。验收阶段需记录用户操作路径,分析界面交互卡顿点,例如某项目通过简化数据校验步骤,使操作效率提升28%。最终签署的UAT报告应明确标注所有问题的解决时效。

五、部署与上线

1、环境配置与部署

部署环境需根据系统架构进行针对性配置。生产环境通常采用云服务器或本地集群,需确保服务器资源(CPU、内存、存储)满足系统运行需求。数据库部署需考虑主从复制或分片策略以提高可用性。容器化技术(如Docker)可简化依赖管理,结合Kubernetes实现自动化扩缩容。部署脚本应包含版本回滚机制,避免更新失败导致服务中断。

2、上线前的准备工作

上线前需完成数据迁移、权限配置和备份方案验证。数据迁移需保证历史数据的完整性和一致性,建议通过增量同步减少停机时间。权限配置需遵循最小权限原则,区分开发、测试和生产环境访问控制。备份方案应覆盖数据库、日志和配置文件,定期演练恢复流程。同时,需准备应急预案,明确网络故障、数据异常等问题的处理流程。

3、监控与维护

系统上线后需部署实时监控工具(如Prometheus或Zabbix),跟踪服务器负载、API响应时间和数据采集成功率等关键指标。日志集中管理(ELK栈)有助于快速定位问题。定期维护包括数据库索引优化、缓存清理和依赖库升级。通过A/B测试或灰度发布验证新功能稳定性,持续收集用户反馈以驱动迭代优化。

结语

从零搭建生产与数据采集集成软件项目涉及多个关键环节,包括项目规划、系统设计、开发集成、测试优化以及部署上线。每个阶段都需要严格把控,确保项目顺利进行。项目规划阶段需明确目标和范围,分析业务流程和数据采集需求,选择合适的技术栈和工具。系统设计阶段需构建合理的架构,设计高效的数据采集与处理流程,并优化数据库结构。开发集成阶段需完成数据采集模块、数据处理与分析模块的开发,并实现系统集成与API对接。测试优化阶段需进行功能测试、性能测试和用户验收测试,确保系统稳定可靠。部署上线阶段需完成环境配置、上线准备以及后续的监控维护工作。

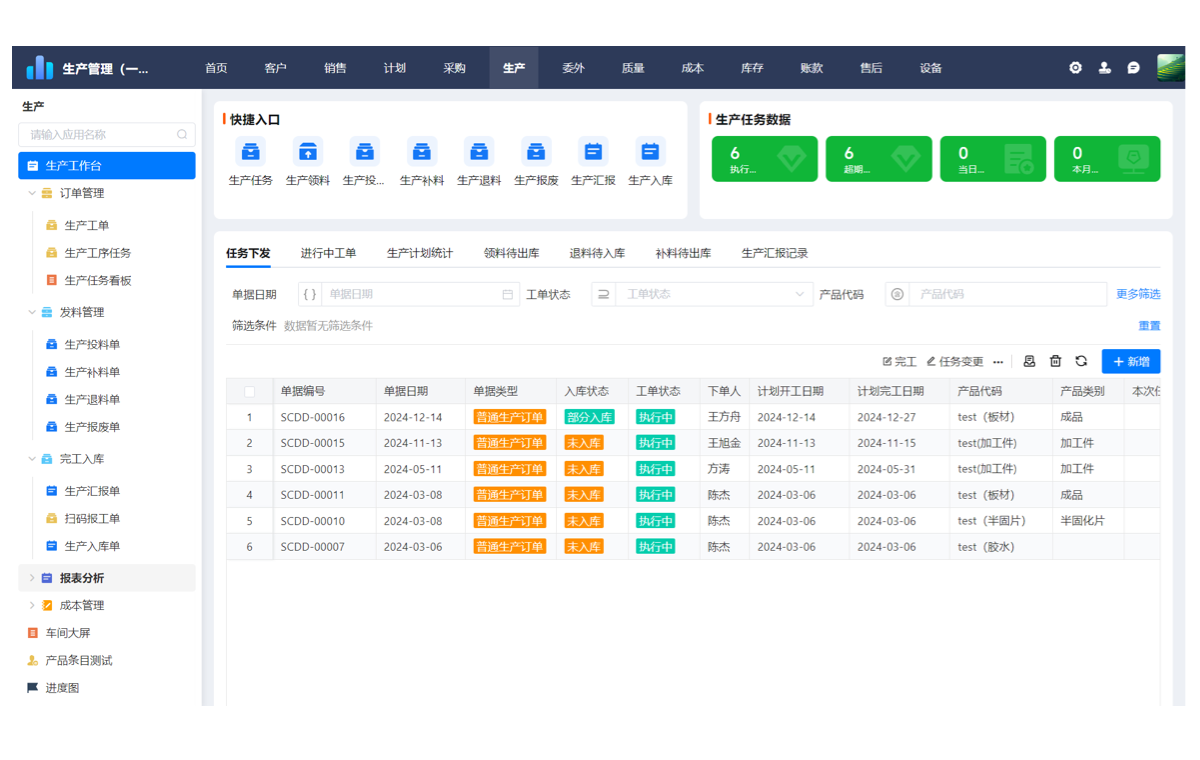

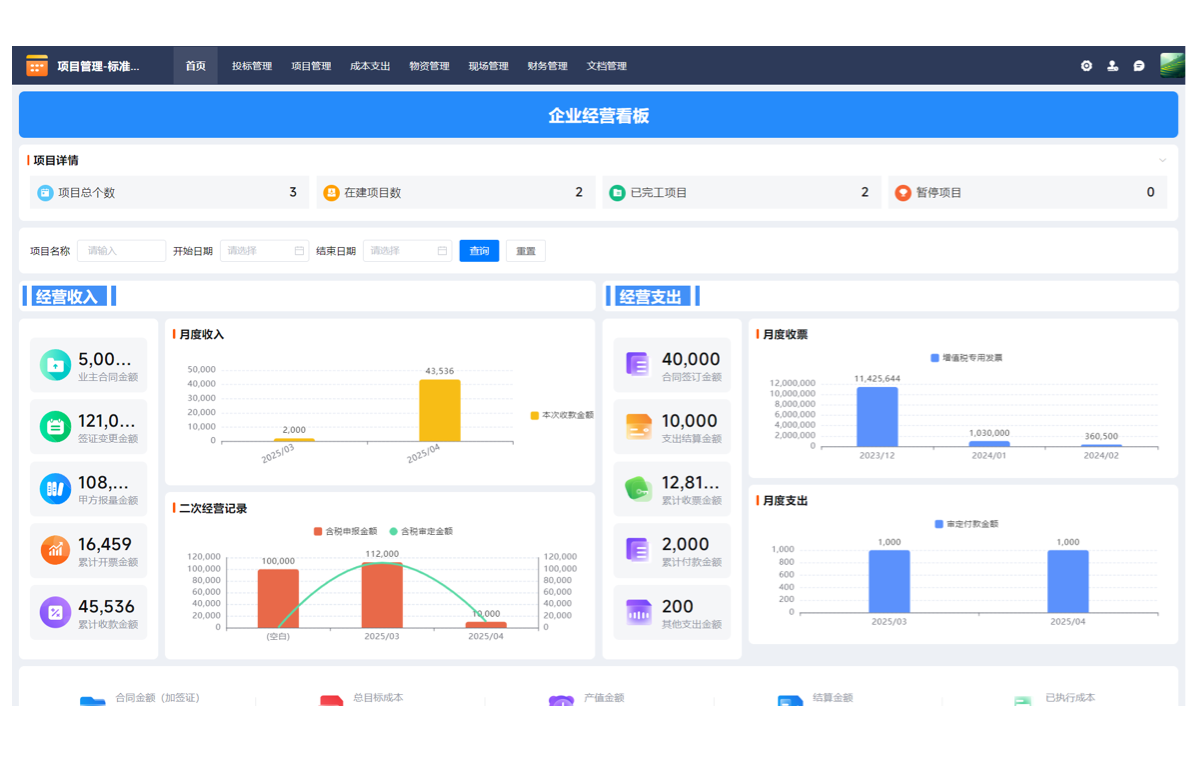

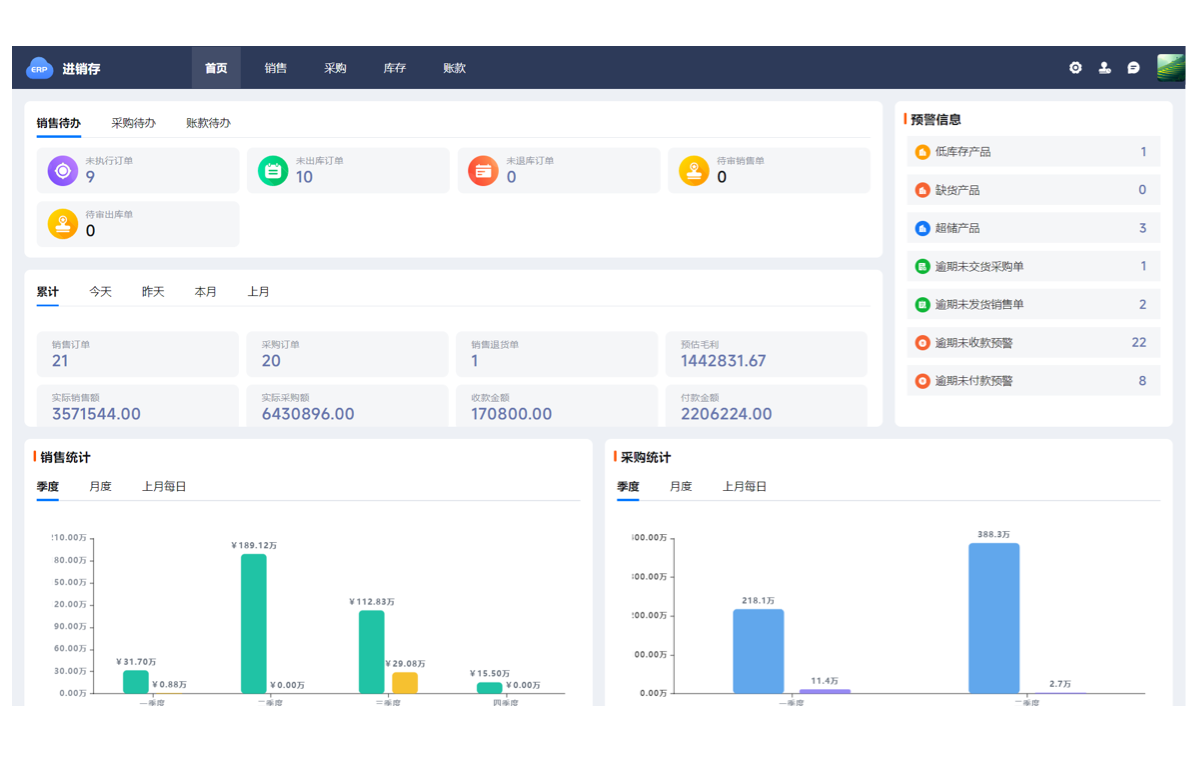

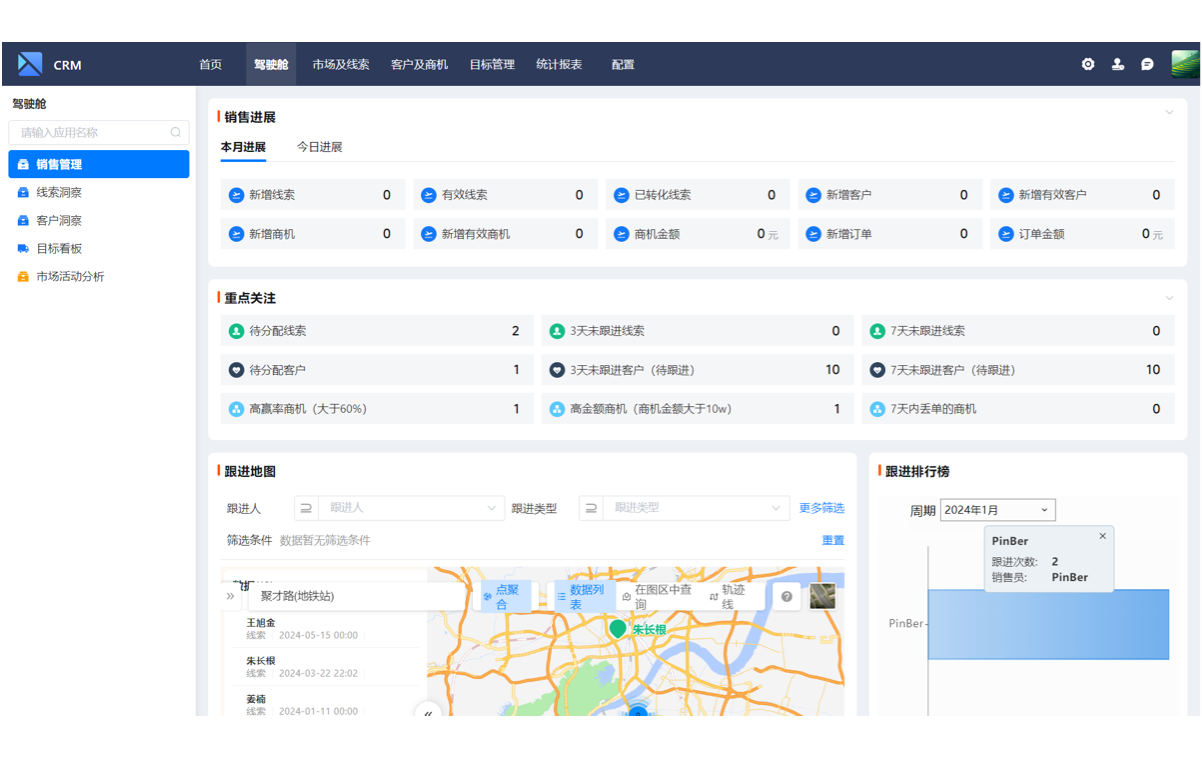

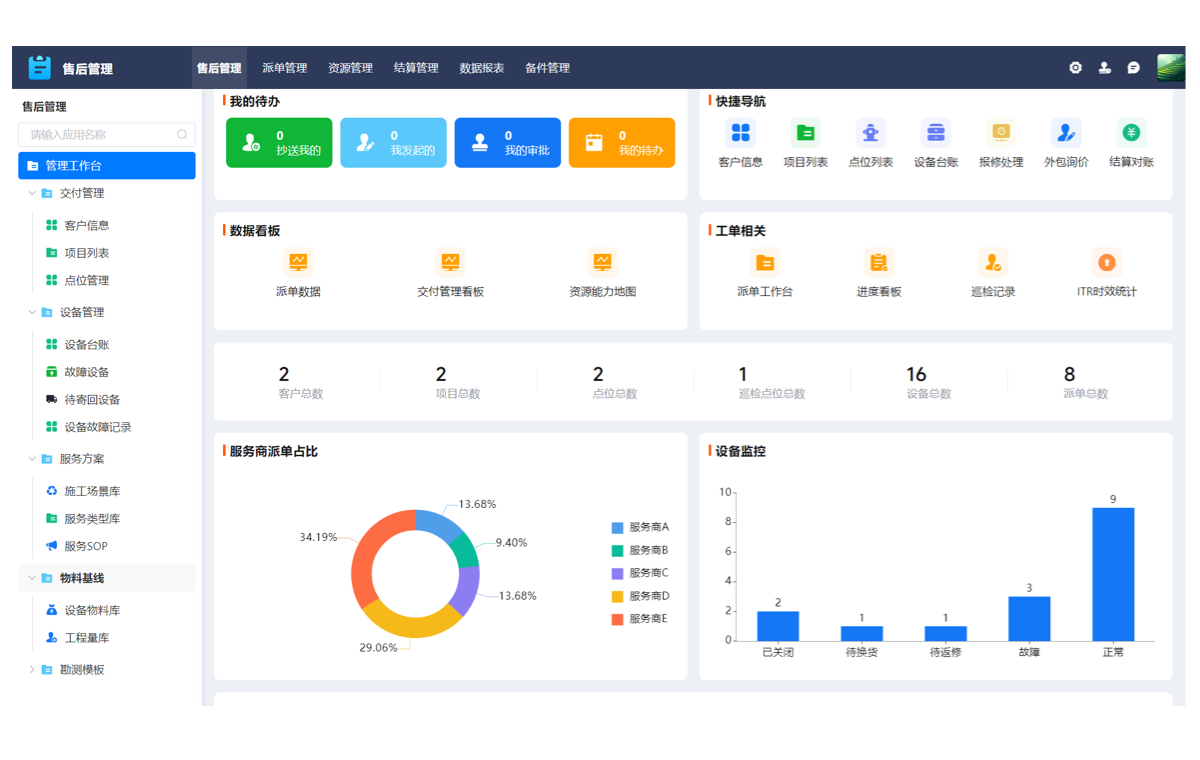

支道平台在无代码应用搭建中展现出显著优势,其拖拉拽配置功能简化了开发流程,降低了技术门槛。多端协同办公能力提升了团队协作效率,帮助用户快速实现项目目标。通过支道平台,企业可以高效完成生产与数据采集集成软件的搭建,节省开发成本,缩短项目周期,同时确保系统的灵活性和可扩展性。

常见问题

1、如何选择适合的技术栈和工具?

选择技术栈和工具需综合考虑项目规模、团队技能和业务需求。对于数据采集类项目,优先考虑支持高并发、低延迟的框架,如Node.js或Go语言。数据库选型需区分实时分析(ClickHouse)与事务处理(PostgreSQL),同时集成Kafka等消息队列应对流量峰值。支道平台的无代码特性可快速实现表单设计和API对接,适合非核心模块开发。

2、数据采集过程中如何保证数据的准确性和完整性?

采用校验规则和冗余设计是关键。在数据入口层设置格式验证(如JSON Schema),通过时间戳和唯一标识符追踪数据链路。分布式场景下需实现幂等性处理,避免重复采集。支道平台的数据管道模块提供自动重试机制,异常数据会进入隔离区人工审核,确保最终一致性。

3、支道平台在项目中有哪些具体的应用场景?

支道平台适用于快速构建数据看板、工单管理系统等标准化模块。其可视化工作流引擎能配置数据清洗规则,将原始数据转换为结构化格式。在设备监控场景中,通过支道对接PLC和传感器数据,实时触发预警通知。对于跨部门协作需求,可利用平台的权限管理和多端同步功能实现移动端数据录入与审批。