告别救火,你的团队是否也陷入了“质量异常”的混乱漩涡?

半夜刺耳的电话铃声,是产线停摆的告急;多部门拉起的紧急会议,最终却变成了责任归属的拉锯战;客户的愤怒投诉邮件,正在一步步侵蚀辛苦建立的品牌信任。更令人沮丧的是,类似的问题反复出现,而每一次的处理方案,似乎都得“从零开始”。

在服务超过5000家企业的过程中,我们发现这种混乱的根源,往往不在于团队的执行力,而在于面对突发异常时,缺少一个清晰、统一的“预设剧本”。这正是高效的质量异常响应机制所要解决的核心问题。它不是事后的补救,而是贯穿事前、事中、事后的系统化作战蓝图,能带领团队走出“救火队员”的困境。

本文将为你完整描绘这个蓝图,拆解一个从预警到闭环的标准化响应机制。

什么是高效的质量异常响应机制?它不是什么,又是什么

在构建之前,我们必须先对“质量异常响应机制”建立正确的认知。

首先,它不是:

- 临时的“救火队”: 它不是问题发生后才临时组建的突击小组,其核心在于预先定义的流程和角色。

- 追责与处罚的工具: 它的首要目标是解决问题、恢复业务,而非定位“背锅侠”。一个以惩罚为导向的机制,只会让问题被隐藏。

- 一套束之高阁的复杂文件: 如果一套机制只是为了“看起来很专业”而存在,不能在实战中被快速调用和执行,那它就毫无价值。

那么,它究竟是什么?

- 一个标准化的快速反应框架(SOP): 它为“谁在什么时候,应该做什么”提供了明确的指令,确保响应动作不跑偏、不遗漏。

- 一个驱动持续改进的数据闭环系统: 它不仅处理当下的问题,更重要的是记录、分析并追踪问题根源,将每一次异常都转化为组织能力提升的契机。

- 一个保障业务稳定与客户信任的“免疫系统”: 它能主动发现威胁,快速调动资源进行处理,并通过“学习”来预防同类问题的再次发生。

一个设计良好的响应机制,其核心价值可以归纳为四个字:

- 快: 极大缩短从发现问题到启动处理的时间,分秒必争,减少业务损失。

- 准: 精准地将信息传递给正确的责任人,并运用系统化方法定位根本原因。

- 稳: 在混乱中建立秩序,稳定团队情绪,让每个人都清楚自己的位置和职责。

- 升: 通过复盘和根因分析,沉淀经验与教训,实现问题的真正闭环,持续提升整体质量水平。

机制的核心构成:拆解一个完整的质量异常响应闭环

一个成熟的响应机制,通常包含预警、响应、处置、分析、闭环五个核心模块。它们环环相扣,构成了一个完整的数据和管理流。

模块一:预警 (Warning) - 在问题失控前发现信号

预警是整个响应机制的起点,目标是在问题造成大规模影响前,尽可能早地捕捉到异常信号。

- 预警来源: 来源必须多样化。既包括来自各类业务系统、设备传感器的自动化数据监控,也需要覆盖产线员工、测试团队、客服部门等渠道的人工上报。

- 预警分级: 并非所有异常都需同等对待。必须预先定义清晰的预警等级(如P0/P1/P2),并明确每个等级的触发条件,例如“影响核心交易链路”为P0,“影响单个边缘功能”为P2。

- 预警方式: 信息必须确保能够必达。根据不同等级,应采用组合式的通知策略,例如通过专业的事件管理平台(如我们的支道产品)、短信、电话、甚至语音呼叫,确保关键信息在3分钟内触达第一响应人。

模块二:响应 (Response) - 秒级启动,精准定位

收到预警后,必须立刻进入响应流程,其核心是“有序”。

- 确认与受理: 指定明确的“第一响应人”(On-call Engineer),其首要职责是在规定时间内(如5分钟内)快速确认异常的有效性,避免资源浪费。

- 信息通报: 一旦异常被确认,应立即启动标准化的信息通报流程,通过预设的渠道,将事件简报同步给所有需要知晓的相关方。

- 组建应急小组: 根据预警等级,自动或手动组建应急处理小组。P0级异常可能需要CEO、CTO直接介入,而P2级异常可能仅需一线主管和工程师处理。

- 明确责任人矩阵: 混乱往往源于职责不清。我们强烈建议使用责任分配矩阵(RACI)来明确角色:谁负责决策 (Accountable)、谁负责执行 (Responsible)、谁需要被咨询 (Consulted)、谁需要被告知 (Informed)。

响应模块的核心是快、准、稳,确保正确的人在第一时间收到正确、完整的信息,并立刻进入自己的角色。

模块三:处置 (Containment & Resolution) - 控制影响,恢复秩序

处置阶段包含两个关键动作,目标是先“止血”,再“治病”。

- 应急处置(止血): 这是第一要务。快速执行降级、回滚、切换备用方案等临时措施,不追求完美,只为尽快控制问题影响范围,让核心业务恢复运转。

- 标准作业程序(SOP): 对于高频发生或影响重大的异常类型,必须提前准备好相应的处置SOP。当同类问题再次发生时,执行人只需“按图索骥”,极大提升处置效率和准确性。

模块四:分析 (Analysis) - 深入根因,而非停留表面

业务恢复后,工作只完成了一半。如果不能找到问题的根本原因,它大概率会再次出现。

- 引入根本原因分析 (RCA): 这是从此阶段开始的核心方法论。团队需要从“解决了什么”转向“为什么会发生”。

- 常用工具: “5 Whys(五问法)”通过连续追问来深挖原因;“鱼骨图”则从人、机、料、法、环、测等维度系统化地排查可能因素。

- 核心目的: 分析的重点是找到系统性、流程性的缺陷,而非追究个人责任。只有这样,才能鼓励团队成员坦诚地暴露问题。

模块五:闭环 (Closure & Improvement) - 从一次异常中收获长期价值

这是决定一个响应机制能否带来长期价值的关键一步。

- 制定纠正与预防措施 (CAPA): 针对分析出的根本原因,制定具体的、可追踪的、有明确责任人和截止日期的改进计划。这既包括修复技术Bug的“纠正措施”,也包括优化流程、增加监控等“预防措施”。

- 复盘总结: 组织正式的复盘会议(Post-mortem),回顾整个事件的处理过程,总结经验教训,并将有效的处置方案和分析结果固化到知识库和SOP中。

- 验证与关闭: 在所有改进措施完成后,需要有专人验证其有效性,确保问题根源已被消除。最终,正式关闭该异常事件,形成一次完整的管理闭环。

[CTA] 下载《质量异常响应机制自查与搭建模板》

如何从0到1搭建你的质量异常响应机制?(四步实施指南)

基于服务数千家企业的实践经验,我们总结出了一套从0到1的四步实施路径。

第一步:定义异常与分级

首先,你需要和业务、技术团队一起,全面梳理业务中可能发生的各类关键质量异常。然后,为这些异常设定清晰的严重等级(如P0-P3)以及对应的业务影响评估标准。例如,P0代表“核心业务中断,造成重大营收或声誉损失”,P3则代表“内部系统体验问题,无直接客户影响”。

第二步:明确角色与职责

基于定义好的异常等级,建立你的“责任人矩阵”(RACI)。明确每个等级的异常,由谁上报、由谁担任第一响应人、由谁负责指挥决策、由谁负责具体执行。这份矩阵应成为全公司的共识,并对关键岗位进行培训。

第三步:设计并固化流程

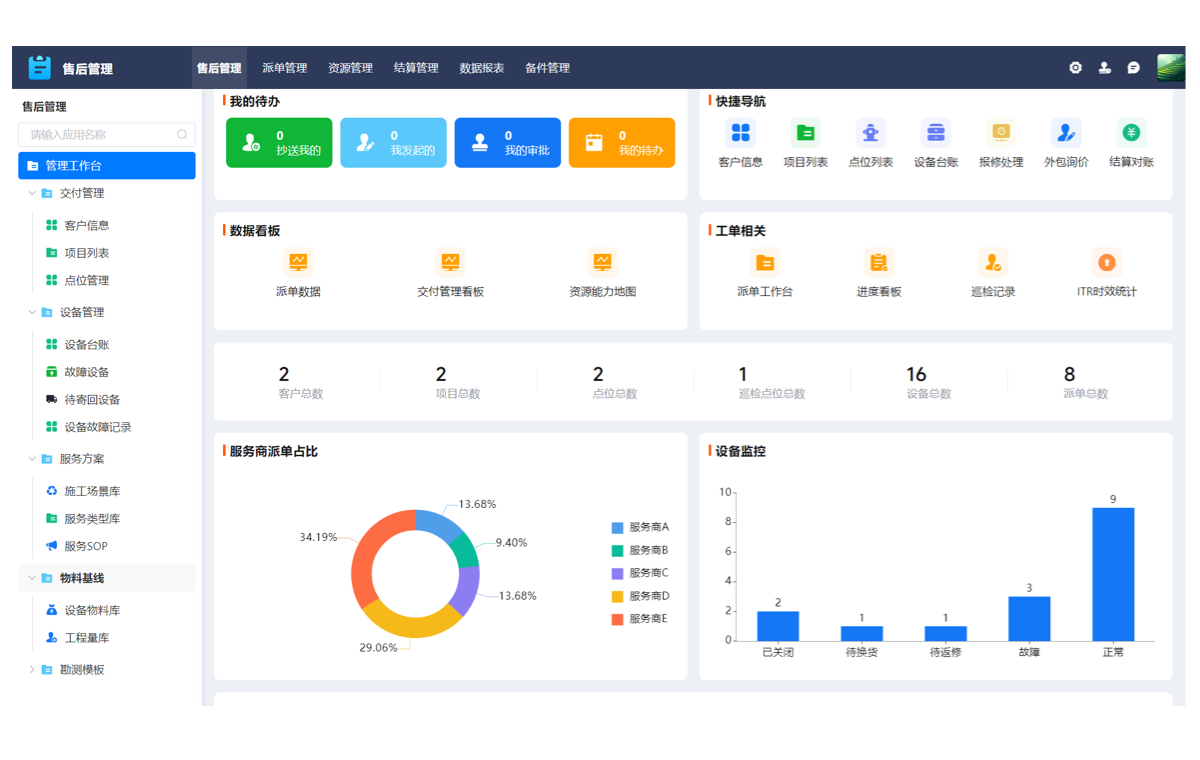

将预警、响应、处置、分析、闭环这五个模块串联起来,绘制出清晰的流程图。更关键的是,要将设计好的流程固化到专业工具中。例如,使用支道产品这样的平台,可以将分级标准、通知策略、责任人矩阵和处理步骤配置到系统中,实现工单的自动化流转、数据追踪和过程留痕。

第四步:演练、迭代与优化

机制不是一成不变的。你需要定期组织不同场景下的异常演练,就像消防演习一样,检验流程的有效性和团队的熟练度。根据演练和真实事件的处理经验,不断复盘,持续迭代优化你的响应机制,使其能真正适应业务的发展变化。

成功落地响应机制的3个关键与2个误区

成功的3个关键

- 高层支持: 必须获得管理层的全力支持。响应机制的建设应被视为企业核心能力的投资,而非IT部门的内部事务。

- 无惩罚文化: 建立一种鼓励主动暴露问题的“安全”文化。焦点永远是改进流程和系统,而不是责备犯错的个人。

- 工具赋能: 善用专业工具来承载和驱动流程。工具不仅能提升效率,更能将流程标准化,并将每一次异常处理过程沉淀为可分析、可追溯的数据资产。

必须规避的2个误区

- 有响应无闭环: 这是最常见的失败模式。团队满足于“救火成功”,却从不进行根因分析和制定预防措施,导致同一个“坑”反复掉进去。

- 机制僵化: 机制建立后便束之高阁,从不根据业务变化、技术架构演进或组织调整进行更新,最终导致流程与现实脱节,无法执行。

结语:从被动响应到主动预防,构建企业的质量免疫力

一个高效的质量异常响应机制,其终极目标并不仅仅是“快速响应”。通过对每一次异常的深度分析和持续改进,企业能够逐步消除系统中的脆弱点,最终实现从“被动响应”到“主动预防”的转变。

这不仅仅是一套管理流程,更是企业在数字化时代构建自身“质量免疫力”的核心工程。当这套系统真正运转起来时,你的团队才能从无尽的救火中解放出来,将精力聚焦于创造更大的业务价值。