为什么你的变更报表总是吃力不讨好?

在与超过 5000 家企业决策者交流的过程中,我们发现一个普遍现象:许多团队投入大量精力制作研发变更跟踪报表,结果却不尽如人意。管理者看不到关键洞察,执行者则被繁琐的流程所累。问题并非出在“跟踪变更”这件事本身,而在于“如何跟踪”。传统的手工汇总方式,注定会带来三大难题。

1. 痛点一:耗时耗力,数据永远“慢半拍”

最典型的工作流是:项目经理或团队负责人每周、每月从 Jira 导出需求与缺陷数据,从 GitLab 拉取代码提交记录,再从发布系统里找到上线变更清单。这些数据被手动粘贴到一张巨大的 Excel 表格中,经过繁琐的 VLOOKUP 和数据透视表操作,最终拼凑出一份报表。

这个过程不仅耗费大量高价值人力,更致命的是其“滞后性”。当报表最终完成时,它反映的已经是几天甚至一周前的情况。基于过时的数据做决策,无异于看后视镜开车,无法对当前和未来的风险做出及时反应。

2. 痛点二:口径不一,数据准确性无法保证

当数据源自不同系统、由不同角色手动汇总时,统计口径的统一便成为一个几乎不可能完成的任务。

例如,“一次变更”到底如何定义?是指一个 Jira 任务的完成,一次代码合并请求 (Merge Request),还是一个生产环境的发布包?如果产品团队、开发团队和运维团队的理解不一致,汇总出的数据就会出现偏差甚至矛盾。报表的准确性一旦被质疑,其作为决策依据的价值便会荡然无存。

3. 痛点三:缺乏洞察,只看到“变更了什么”,看不到“影响了什么”

一份只罗列了“本周合并了 50 次代码”、“修复了 20 个缺陷”的报表,价值是极其有限的。因为它只回答了“What”,没有回答“So What”。

管理者真正需要知道的是:

- 我们的变更速度是变快了还是变慢了?(效率)

- 频繁的变更是否引发了更多的线上故障?(质量)

- 哪类变更(新功能、缺陷修复、技术重构)占用了团队最多的精力?(资源分配)

- 一次需求从提出到最终上线,平均需要多长时间?(交付周期)

传统的手工报表无法将分散在不同工具中的过程数据关联起来,自然也无法提供这类深层洞察。

核心观点:高效的报表是“自动生成”的,不是“手动制作”的

问题的根源在于,我们试图用一种前工业时代的“手工作坊”模式,去度量和管理高度复杂的数字化研发活动。要从根本上解决问题,唯一的出路是实现报表体系的自动化,让数据在系统间自由流动,自动计算、自动呈现。

告别手工制作,三步构建自动化研发变更跟踪报表体系

构建一个自动化的报表体系并非遥不可及。根据我们的实践经验,只需遵循以下三个步骤,就能建立一个从数据源到可视化洞察的完整闭环。

1. 第一步:统一数据源,打通变更信息孤岛

自动化报表的基础是数据的互联互通。变更的全貌散落在研发流程的各个环节,必须将它们连接起来,形成统一、可信的数据源。这通常涉及以下几类核心系统:

- 需求与缺陷数据:连接团队使用的项目管理工具,如 Jira、ONES、禅道等,获取需求、任务、缺陷的创建、流转和关闭状态。

- 代码提交与合并数据:连接代码仓库,如 GitLab、GitHub、Gitee 等,捕获每一次代码提交、分支合并、代码评审等工程活动。

- 版本发布数据:连接 CI/CD 流水线工具,如 Jenkins、GitLab CI 等,关联每一次构建、部署和发布的记录,特别是生产环境的发布事件。

只有将这三类数据源打通,才能完整地追踪一次变更从“想法”到“代码”再到“上线”的全过程。

2. 第二步:定义关键指标,让报表“会说话”

原始数据本身没有意义,必须将其转化为能够衡量效率、质量和风险的指标,报表才能提供洞察。在研发效能领域,业界已经形成了一套成熟的度量标准,我们将其归纳为三大类:

-

变更频率与规模指标

- 变更频率 (Change Frequency):衡量单位时间内生产环境的部署次数,是评估团队交付吞吐率的核心指标。

- 需求变更率 (Requirement Volatility):分析在开发周期中,需求发生变更或增加的比例,反映需求的稳定性和规划质量。

- 代码提交次数 (Commit Count):作为辅助指标,观察团队代码活动的活跃度。

-

变更效率与流程指标

- 变更前置时间 (Change Lead Time):从代码提交到功能成功上线所需的时长,直接反映了价值交付的速度。这是 DORA 核心指标之一。

- 缺陷修复时长 (Bug Resolution Time):从缺陷被发现到被修复上线所花费的时间,衡量团队响应和解决问题的能力。

-

变更质量与风险指标

- 变更失败率 (Change Failure Rate):生产环境的变更导致服务降级或需要修正(如回滚、热修复)的百分比。这是衡量变更质量和稳定性的关键 DORA 指标。

- 热修复 (Hotfix) 占比:在所有变更中,紧急修复性质的变更占多大比例,可以间接反映研发流程的规范性和代码质量。

3. 第三步:实现自动化与可视化,从数据到洞察

有了统一的数据源和明确的指标模型,最后一步就是让这一切自动运转起来,并以直观的方式呈现。

-

建立自动化数据流:通过专业的研发效能平台或数据工具,配置好与各个数据源的连接。系统会根据预设的规则,自动、周期性地拉取最新数据,并完成指标的计算和整合,彻底告别手工操作。

-

选择合适的可视化图表:

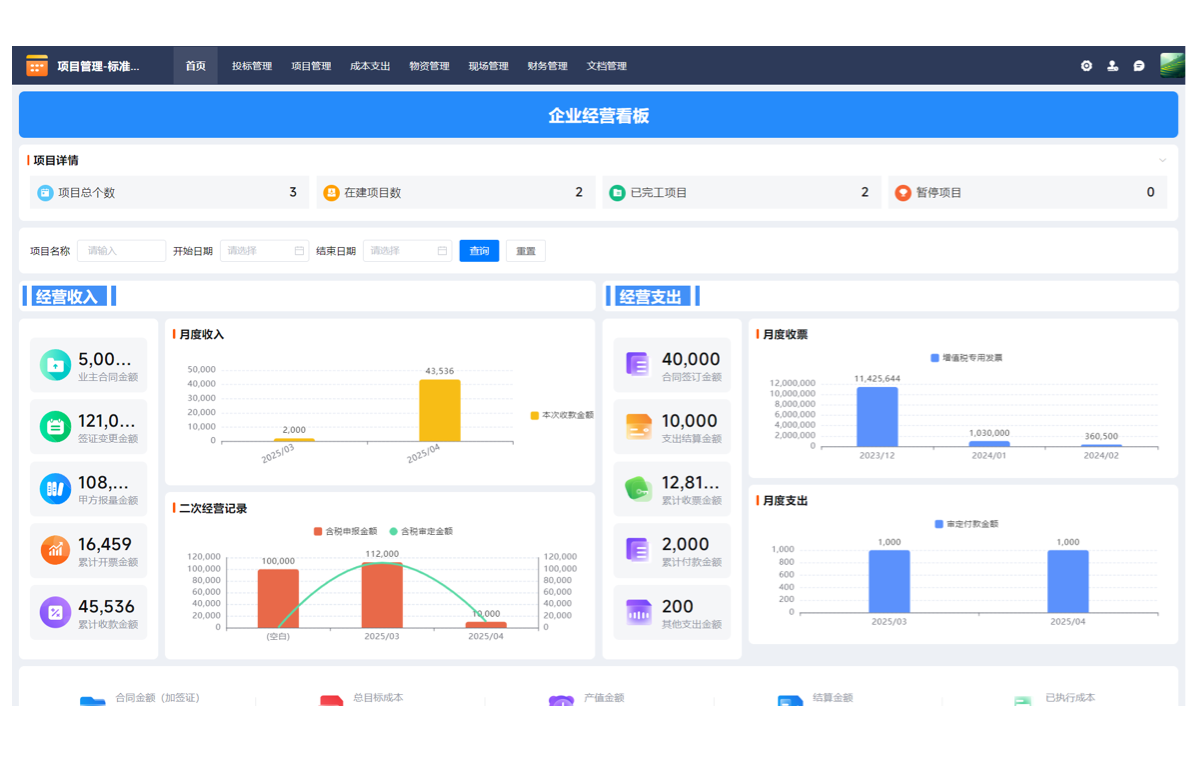

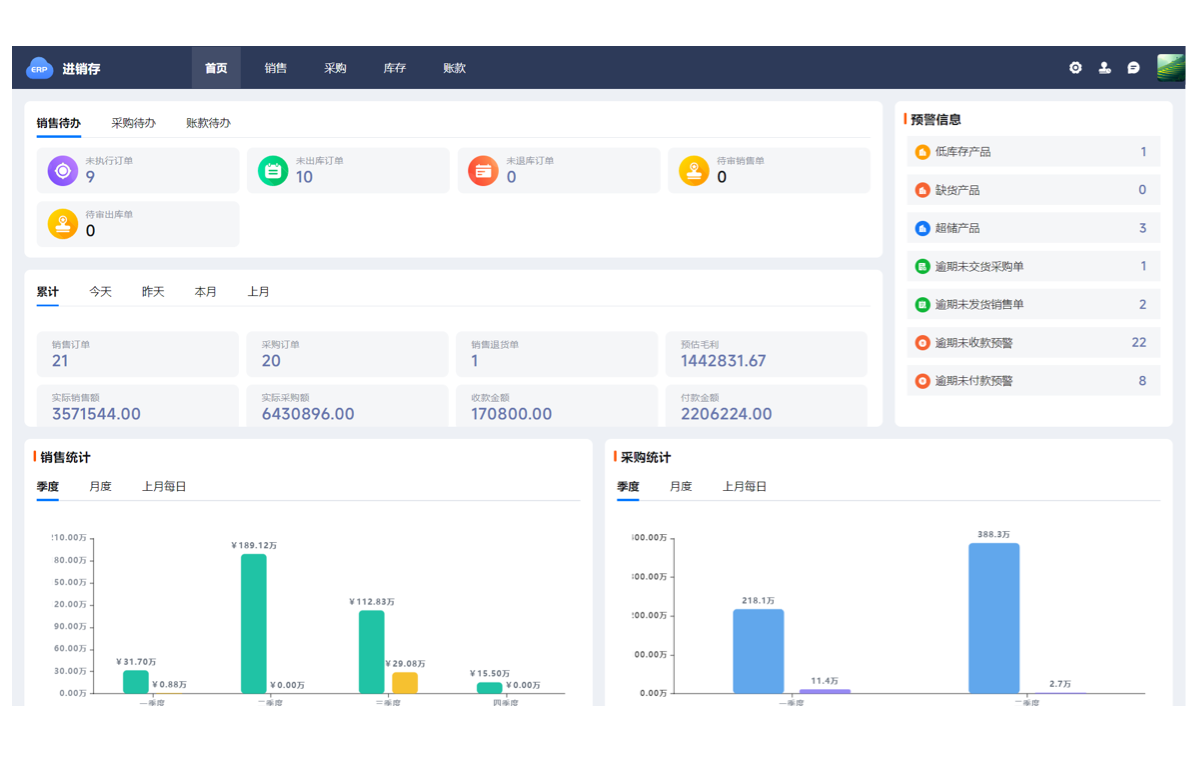

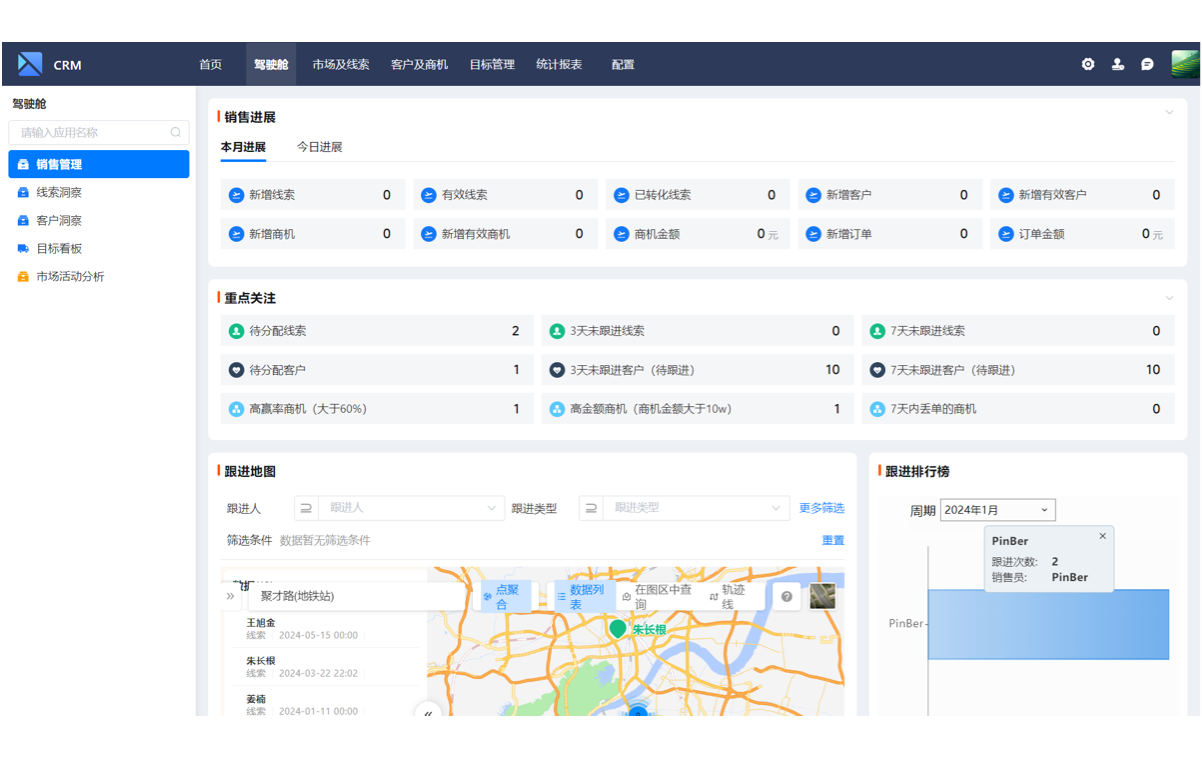

- 使用趋势图:跟踪变更频率、变更前置时间等核心指标随时间的变化,直观判断团队效能的演进趋势是向好还是恶化。

- 使用分布图:分析不同变更类型(如功能、缺陷)的占比,或者缺陷修复时长的分布情况,帮助定位流程瓶颈。

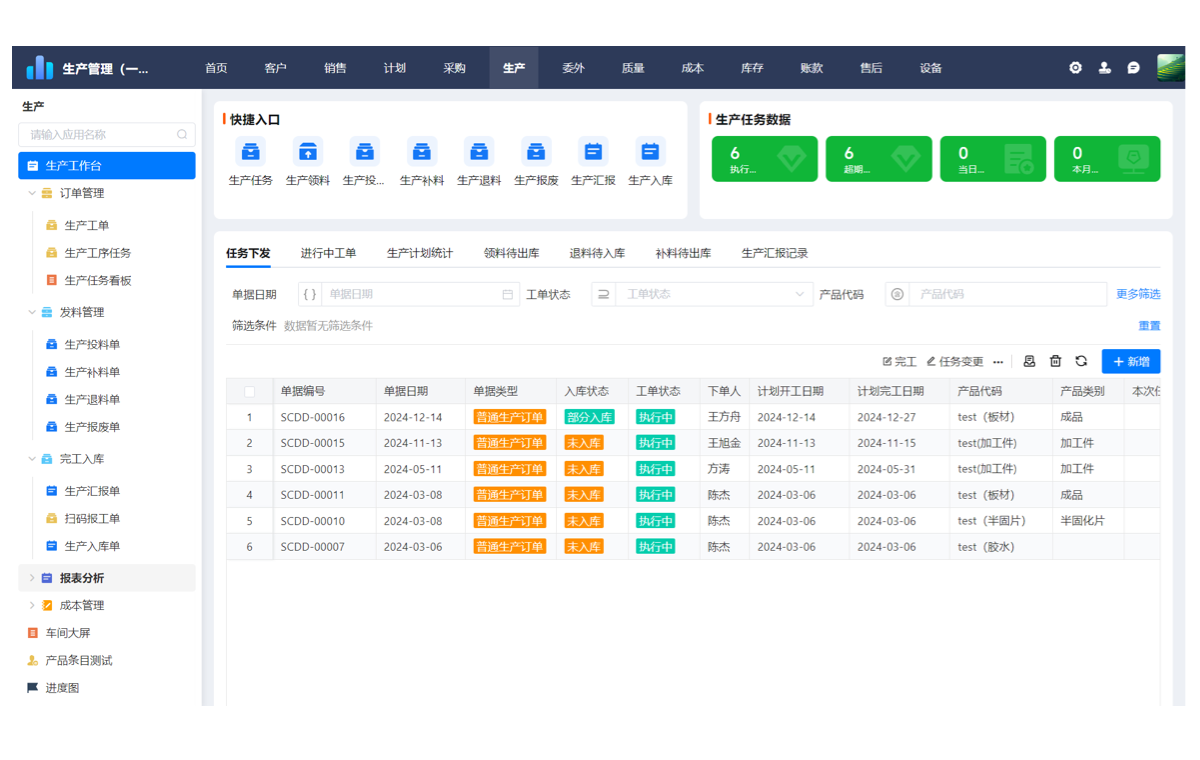

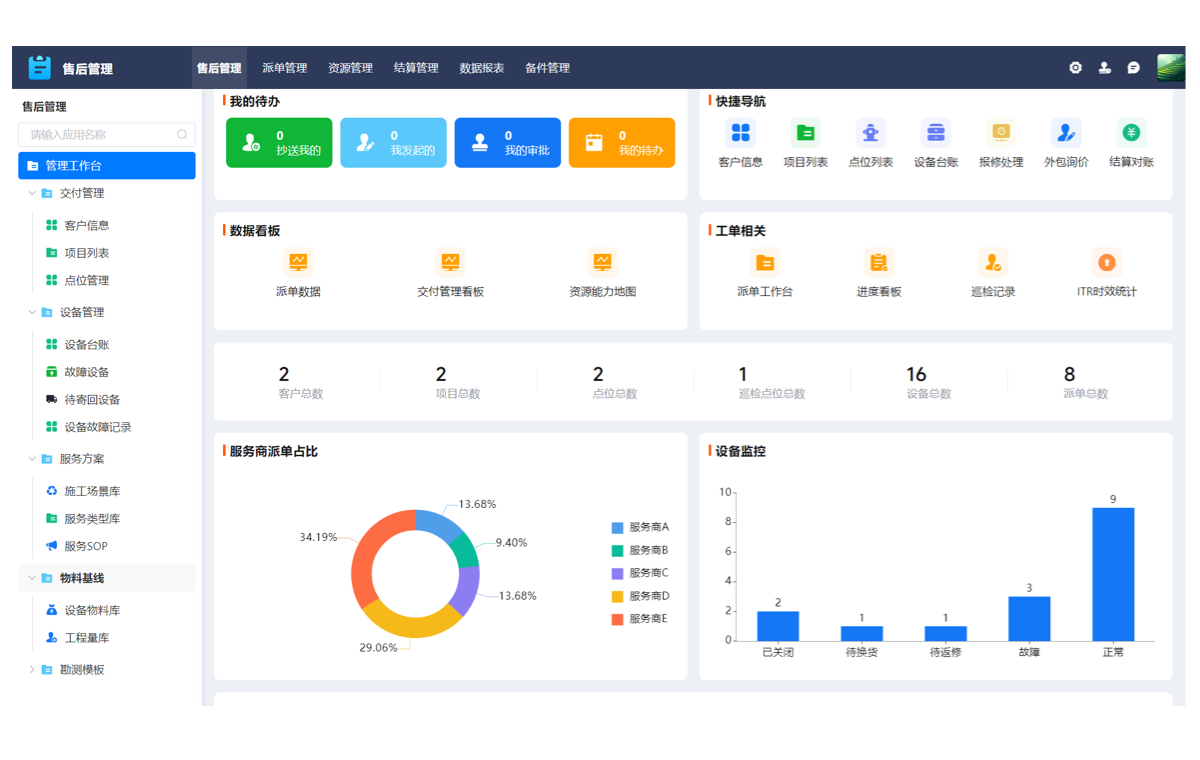

- 使用仪表盘:将所有核心指标集中呈现在一个视图中,为管理者构建一站式的管理驾驶舱,实时掌握研发健康度。

-

核心要点小结:连接数据源 → 定义指标 → 自动生成可视化图表,这是从繁琐的手工报表迈向高效数据驱动决策的唯一通路。

如何选择合适的变更报表生成工具?

当决定引入工具来解决问题时,正确的评估标准至关重要。基于对市场的观察和企业实践的分析,我们建议决策者从以下三个核心原则出发进行评估。

1. 评估原则一:数据源集成能力

这是最基础、也是最关键的一环。工具必须能够与团队现有的技术栈无缝对接。在评估时,需要明确:

- 它是否能无缝对接团队现有的 Jira、GitLab、Jenkins 等核心研发工具?

- 集成过程是需要投入大量开发资源进行定制,还是提供开箱即用的连接器?

- 数据同步的实时性和稳定性如何?

一个无法与你的工作流顺畅集成的工具,无论功能多么强大,最终都难以落地。

2. 评估原则二:指标模型的专业性与灵活性

工具的价值不仅在于聚合数据,更在于提供科学的度量模型。

- 它是否内置了研发效能领域的标准指标? 例如,是否原生支持 DORA 四大关键指标(变更前置时间、部署频率、变更失败率、平均修复时间)的计算,这体现了工具的专业性。

- 它是否支持根据业务需求进行自定义配置? 不同的业务模式和团队阶段,关注的重点可能不同。工具需要提供足够的灵活性,允许用户调整指标的计算逻辑或创建全新的复合指标。

一个好的工具应该既能提供业界最佳实践,又能适应企业的个性化需求。

3. 评估原则三:自动化与可视化程度

引入工具的核心目的是提升效率,因此自动化和易用性是关键考量点。

- 它能否实现无人值守的数据定时更新? 管理者需要的是随时可用的最新数据,而不是需要手动点击“刷新”才能生成的报表。

- 它是否提供开箱即用的可视化报表和仪表盘模板? 从零开始配置一张图表可能非常耗时。内置针对不同角色(如 CEO、研发总监、项目经理)的预设模板,可以帮助团队快速上手,更快地从数据中获益。

总结:让数据驱动研发,从一张高效的报表开始

一张优秀的研发变更跟踪报表,绝不是研发流程的终点,而是持续改进的起点。它用客观的数据替代主观的感受,将模糊的“感觉”量化为清晰的“事实”,为优化流程、识别风险、提升效率提供决策依据。

告别低效、易错的手工报表,拥抱自动化、智能化的数据平台,是实现数据驱动研发的必经之路。

将理论付诸实践

了解领先的研发团队如何利用「支道」一站式生成研发变更跟踪报表,立即开启免费试用。