在现代企业数字化协同的版图中,办公自动化(OA)系统是当之无愧的神经中枢,而其中的日程管理模块,则扮演着“时间总调度师”的关键角色。它不仅是个人时间管理的工具,更是连接邮件系统、会议预定、项目管理、任务分配等多个核心模块的桥梁。每一次会议邀请的发出,每一次项目里程碑的设定,每一次跨部门协作的安排,都依赖于日程接口精准、稳定地传递信息。然而,一旦这个关键接口出现问题——无论是微小的延迟、偶发的数据错乱,还是严重的数据权限失控——其连锁反应将是灾难性的。会议可能无法准时召开,项目进度可能因此延误,甚至错误的日程信息会误导关键决策的执行。这直接削弱了企业赖以生存的协同效率。因此,对OA日程接口进行系统化、深度的测试与优化,已不再仅仅是技术团队的常规任务,而是从源头上保障企业高效运转的战略性举措。本文旨在提供一套可落地执行的日程接口测试优化策略,帮助企业技术团队构建坚实的质量防线,确保OA系统始终是效率的助推器,而非瓶颈。

一、盘点OA日程接口测试的核心挑战与痛点

作为首席行业分析师,基于对超过5000家企业服务数据的深度洞察,我们发现,尽管OA系统已相当普及,但其日程接口的测试工作仍普遍面临三大核心挑战。这些挑战不仅技术复杂度高,更与企业实际业务场景紧密交织,成为保障系统稳定性的主要痛点。

1. 复杂业务场景的覆盖难题

日程管理看似简单,实则蕴含着极其复杂的业务逻辑。测试若仅停留在简单的增删改查(CRUD),将无法覆盖真实世界中千变万化的使用场景,从而埋下生产环境的隐患。这些场景的逻辑交叉点,正是缺陷的高发区。具体而言,测试团队必须周全考虑:

- 重复日程与周期性规则:如每日站会、每周复盘、每月总结,以及“每双周周三”这类自定义规则的创建、修改与删除,特别是修改其中某一次或后续所有日程的逻辑。

- 全天事件与跨天事件:例如公司年会(全天)或持续数日的外部培训(跨天),其在日历视图上的正确展示、时长计算及冲突检测。

- 多人协作与共享日程:创建涉及多个参与者的日程时,权限控制(谁能修改、谁只能查看)、参与者状态反馈(接受/拒绝/待定)以及变更后的通知机制。

- 资源预定与冲突检测:预定会议室、投影仪等公共资源时,接口需能准确判断资源在指定时间段内的可用性,并处理预定冲突。

- 日程变更与历史追溯:当日程时间、地点或参与者发生变更时,系统能否及时、准确地通知所有相关方,并保留变更记录。

2. 海量数据与高并发下的性能瓶颈

企业规模越大,OA系统的用户量和数据量就越庞大。日程接口需要在高并发场景下保持高性能。例如,在周一上午9点,数千名员工可能同时登录系统查看当天日程,这对日程查询接口构成了巨大的瞬时压力。同样,当HR或行政部门发布全员性质的活动日程时,会瞬间产生大量的写操作。如果接口设计或后端服务能力不足,极易出现响应超时、数据库死锁甚至服务宕机,导致整个OA系统陷入瘫痪。测试团队面临的挑战在于,如何有效模拟这种“洪峰”流量,精准定位性能瓶颈。

3. 跨时区与夏令时处理的逻辑陷阱

对于跨国经营或拥有异地分支机构的企业而言,日程的跨时区处理是一个极其棘手且容易被忽视的问题。接口必须能够正确处理不同时区用户的日程创建、显示和提醒。例如,一位在北京(UTC+8)的员工为一位在纽约(UTC-5)的同事安排了一场线上会议,接口需要确保双方在各自的本地时间视图中看到的时间都是准确的。此外,夏令时(DST)的切换为这一问题增加了另一层复杂性。如果时区和夏令时逻辑处理不当,会导致会议时间错乱,严重影响跨国协作的效率与准确性。

二、测试优化的基石:构建分层且全面的测试用例体系

面对上述挑战,盲目增加测试人力或时间并非良策。优化的第一步,是构建一个结构化、分层且覆盖全面的测试用例体系。这套体系应如同一张精密的渔网,能够捕获从核心功能到极端异常的各类缺陷,为日程接口的质量提供坚实的基础保障。

1. 功能性测试用例设计:从核心CRUD到边界值

功能性测试是验证接口是否按预期工作的基石。我们不仅要覆盖基本的创建(Create)、读取(Read)、更新(Update)、删除(Delete)操作,更要深入到业务逻辑的每一个细节和边界条件。通过表格化的方式管理用例,可以确保逻辑清晰、覆盖全面。

| 测试模块 | 测试点 | 输入数据示例 | 预期结果 | 优先级 |

|---|---|---|---|---|

| 创建日程 (Create) | 必填字段校验 | title为空, startTime为空 |

返回错误码400,提示“标题不能为空”或“开始时间不能为空” | 高 |

| 时间逻辑校验 | startTime > endTime |

返回错误码400,提示“开始时间不能晚于结束时间” | 高 | |

| 创建重复日程 | repeatType: "weekly", repeatUntil: "2024-12-31" |

成功创建一系列周重复日程,数据库中生成对应的实例 | 高 | |

| 参与者与资源 | participants: ["userA", "userB"], resources: ["room101"] |

日程创建成功,userA和userB收到邀请,会议室101被预定 | 中 | |

| 查询日程 (Read) | 按时间范围查询 | startTime: "2024-05-20T00:00:00", endTime: "2024-05-20T23:59:59" |

返回指定日期内的所有日程列表,不多也不少 | 高 |

| 查询单个日程详情 | eventId: "xyz-123" |

返回该日程的完整信息,包括标题、时间、参与者列表及状态 | 高 | |

| 边界值-跨年查询 | startTime: "2024-12-31T23:00:00", endTime: "2025-01-01T01:00:00" |

正确返回横跨两年的日程数据 | 中 | |

| 更新日程 (Update) | 修改时间/地点 | eventId: "xyz-123", newStartTime: "...", newLocation: "..." |

日程信息更新成功,并向所有参与者发送变更通知 | 高 |

| 增/删参与者 | eventId: "abc-456", addParticipants: ["userC"], removeParticipants: ["userA"] |

参与者列表更新,userC收到新邀请,userA的日历中该日程被移除或标记为取消 | 高 | |

| 修改重复日程 | eventId: "repeat-001", scope: "this_event_only"` |

仅修改当前这一个重复日程实例,不影响其他实例 | 中 | |

| 删除日程 (Delete) | 删除单个日程 | eventId: "xyz-123" |

日程被逻辑删除或物理删除,相关参与者收到取消通知 | 高 |

| 删除整个重复系列 | eventId: "repeat-001", scope: "all_future_events" |

删除此实例及之后所有的重复日程实例 | 中 |

2. 异常场景测试用例:模拟真实世界的“意外”

健壮的系统不仅能在正常情况下工作,更能在异常发生时优雅地处理。测试用例必须模拟真实世界中可能发生的各种“意外”,以检验接口的容错能力和稳定性。

- 网络异常:模拟客户端请求发送后网络突然中断,服务器是否能正确处理这个不完整的请求,避免产生“脏数据”。

- 服务器内部错误:通过注入错误或Mock下游服务失败,强制接口返回500 (Internal Server Error),观察客户端或调用方是否能妥善处理,并给出友好提示。

- 数据格式错误:发送不符合API规约的JSON/XML数据(如字段类型错误、缺少关键字段),验证接口是否有严格的格式校验和清晰的错误反馈。

- 并发冲突:模拟两个用户在同一时刻修改同一个日程,检验接口是否具备乐观锁或悲观锁机制,防止数据被覆盖。

- 超时处理:当接口依赖的下游服务(如邮件通知服务)响应缓慢时,主接口是否设置了合理的超时时间,并能正确返回,而不是无限期等待。

- 恶意输入/大数据量:提交包含特殊字符、超长字符串的日程内容,或一次性添加数千个参与者,测试接口的健壮性和处理上限。

3. 权限与安全测试用例:守护数据安全防线

日程数据涉及员工的个人时间安排和公司会议信息,具有高度敏感性。权限与安全测试是绝对不可或缺的一环,旨在确保数据不被未授权访问或篡改。

- 水平越权:尝试使用普通员工A的身份凭证(Token),通过直接修改API请求中的日程ID,去查询或修改属于员工B的私人日程。预期应返回403 (Forbidden)或404 (Not Found)。

- 垂直越权:尝试使用普通员工的身份凭证,去调用只有管理员才能访问的接口,例如“删除任意用户日程”或“查看公司高管日程”的接口。预期应返回403 (Forbidden)。

- 未授权访问:不携带任何身份凭证,直接调用需要登录才能访问的日程接口。预期应返回401 (Unauthorized)。

- 数据泄露:检查日程查询接口的返回数据,确保其中不包含任何不应暴露给当前用户的敏感信息,如其他参与者的私人联系方式等。

- 操作权限分离:验证对于一个共享日程,不同角色的参与者权限是否正确。例如,创建者可以修改所有信息,而普通参与者只能更新自己的“接受/拒绝”状态,不能修改日程时间。

三、效率倍增器:自动化测试策略与工具选型

在敏捷开发和持续集成的背景下,手动执行上述庞大的测试用例体系是不现实的。自动化测试是提升测试效率、缩短反馈周期、保障回归质量的关键。本章将深入探讨如何选择合适的工具并实施高效的自动化策略。

1. 接口自动化测试框架选择(Postman, JMeter等)

选择合适的工具是自动化之旅的第一步。不同的工具有不同的侧重点,企业应根据团队技能、项目需求和未来规划进行综合评估。

| 工具/框架 | 学习曲线 | 脚本维护成本 | 性能测试能力 | 生态与社区支持 |

|---|---|---|---|---|

| Postman | 低。图形化界面友好,上手快,适合手动探索和快速脚本化。 | 中等。对于复杂场景,纯JS脚本的管理和复用性稍弱。 | 基础。内置的Collection Runner可做简单的并发测试,但非专业性能工具。 | 非常强大。拥有庞大的用户社区、丰富的文档和公共API库。 |

| JMeter | 中等。基于Java,纯GUI配置,功能强大但界面相对陈旧,学习有一定门槛。 | 较低。测试计划以JMX文件形式保存,模块化和参数化能力强,易于维护。 | 专业级。专为性能测试设计,支持大规模并发、分布式压测和详尽的报告。 | 非常强大。作为Apache顶级项目,拥有成熟的社区、海量插件和解决方案。 |

| REST Assured | 较高。基于Java的代码库,要求测试人员具备编程能力(Java/Groovy)。 | 低。代码即脚本,可利用IDE、版本控制(Git)和构建工具(Maven)进行专业管理。 | 良好。可与TestNG/JUnit等框架结合,通过编码实现复杂的性能测试场景。 | 良好。在Java开发者社区中广泛使用,与Java生态无缝集成。 |

选型建议:

- 对于初创团队或以功能测试为主的场景,Postman 是快速启动的绝佳选择。

- 当需要进行严肃的性能压测和稳定性评估时,JMeter 是行业标准。

- 如果测试团队具备较强的编码能力,并希望将接口测试纳入统一的DevOps代码管理流程,REST Assured 提供了最大的灵活性和可维护性。

2. 数据驱动测试:如何用一套脚本覆盖万千场景?

数据驱动测试是自动化测试的核心思想,其精髓在于将“测试逻辑”与“测试数据”相分离。我们编写一套通用的测试脚本(测试逻辑),然后准备多组不同的输入数据和预期结果。测试框架会自动遍历数据文件,用每一组数据去执行同一套脚本,从而实现以极低的成本覆盖大量测试场景。

实践方法:通常,我们会将测试数据存储在外部文件中,如CSV、JSON或Excel。

-

CSV (逗号分隔值):结构简单,易于读写,非常适合存储结构化的表格数据,如我们之前设计的创建日程的功能用例。

title,startTime,endTime,expectedStatusCode"Team Meeting","2024-05-21T10:00:00","2024-05-21T11:00:00",201"","2024-05-21T10:00:00","2024-05-21T11:00:00",400"Invalid Time","2024-05-21T12:00:00","2024-05-21T11:00:00",400

-

JSON (JavaScript Object Notation):能表示更复杂的数据结构,如嵌套对象和数组,非常适合模拟复杂的API请求体。

伪代码示例 (以Postman/JavaScript为例):

// 假设我们有一个名为 "test-data.csv" 的数据文件// Postman的Collection Runner可以关联这个CSV文件// 1. 在Pre-request Script中,Postman会自动从CSV加载一行数据到data变量// pm.iterationData.get("variable_name") 可以获取对应列的值const requestBody = { "title": pm.iterationData.get("title"), "startTime": pm.iterationData.get("startTime"), "endTime": pm.iterationData.get("endTime")};pm.globals.set("requestBody", JSON.stringify(requestBody));// 2. 在Request Body中,使用变量 {{requestBody}}// {{requestBody}}// 3. 在Tests (Post-request Script) 中,验证响应const expectedStatusCode = parseInt(pm.iterationData.get("expectedStatusCode"));pm.test(`Status code should be ${expectedStatusCode}`, function () { pm.response.to.have.status(expectedStatusCode);});if (expectedStatusCode === 400) { pm.test("Response body should contain error message", function () { const responseJson = pm.response.json(); pm.expect(responseJson.message).to.not.be.empty; });}通过这种方式,我们只需维护一套脚本和一份数据文件,即可轻松覆盖正常、异常、边界等数十上百个测试用例。当需求变更或新增场景时,往往只需在数据文件中添加几行,极大地提升了测试的效率和可维护性。

四、性能与稳定性压舱石:专项性能测试实践

功能正确是基础,但在企业级应用中,性能和稳定性同样是生命线。一次成功的全员线上活动,背后可能意味着对日程接口数万次的并发调用。专项性能测试的目的,就是模拟这种高压场景,主动暴露系统的性能瓶颈和脆弱点,确保其在高负载下依然稳如磐石。以下是实施性能测试的四个关键步骤:

-

定义清晰的性能指标 (KPIs)在开始测试前,必须与产品、运维团队共同明确衡量“好”与“坏”的标准。这些指标是性能测试成功与否的度量衡。

- 吞吐量 (TPS/QPS):Transactions Per Second / Queries Per Second,即服务器每秒能成功处理的请求数。这是衡量系统处理能力的核心指标。例如,目标定义为“核心查询接口在500并发用户下,TPS不低于1000”。

- 响应时间 (Response Time):从发送请求到接收到完整响应所花费的时间。通常关注平均响应时间和95%或99%分位响应时间,后者更能反映大多数用户的真实体验。例如,目标定义为“95%的日程创建请求响应时间应在200ms以内”。

- 错误率 (Error Rate):在压力测试期间,失败请求(如HTTP 5xx错误、超时)占总请求数的比例。目标通常是“错误率必须低于0.1%”。

-

设计贴近真实的测试场景性能测试场景的设计不应是凭空想象,而应基于对线上用户行为的分析。无效的场景只会浪费资源。

- 基准测试:从单个接口开始,逐步增加并发用户,测试其性能极限,找到拐点。

- 负载测试:模拟正常业务高峰期的负载,持续运行一段时间(如1小时),观察系统各项指标是否稳定在可接受范围内。例如,模拟周一上午9:00-10:00,80%的用户在查询日程,20%的用户在创建或修改日程。

- 压力测试(峰值测试):模拟业务量达到历史峰值,甚至超过预期峰值(如1.5倍)的场景,测试系统的极限承载能力。例如,模拟CEO发布全员信,瞬间触发上万个日程通知。

- 稳定性测试(浸泡测试):在中等负载下长时间运行(如8小时或24小时),旨在发现因内存泄漏、数据库连接池耗尽等缓慢累积导致的问题。

-

执行与监控:透视系统内部状态使用JMeter等工具执行测试脚本的同时,必须借助监控工具深入观察服务器的“健康状况”。只看压测工具的报告是远远不够的。

- 应用服务器监控:实时监控CPU使用率、内存占用(特别是JVM的堆内存使用和GC情况)、线程数、网络I/O等。

- 数据库监控:监控数据库的CPU/内存、磁盘I/O、活跃连接数、慢查询日志等。慢查询是导致接口性能问题的最常见原因之一。

- 中间件监控:如Redis缓存的命中率、Nginx的连接数和响应时间等。

- 全链路监控:使用APM(Application Performance Management)工具如SkyWalking、Pinpoint,可以清晰地看到一个请求在后端微服务调用链中的完整耗时分布,快速定位瓶颈。

-

分析瓶颈与调优测试的最终目的是发现问题并推动解决。当性能指标不达标时,需要根据监控数据进行系统性分析。

- CPU占用过高:可能是代码中存在死循环、复杂的计算逻辑,或正则表达式性能不佳。需要通过CPU Profiling工具定位热点代码。

- 响应时间长但CPU不高:大概率是I/O瓶颈。最常见的是数据库慢查询,需要优化SQL语句或为相关字段添加索引。也可能是等待下游服务响应过慢。

- 内存持续增长(内存泄漏):通常是代码中创建了对象但未能被垃圾回收机制回收。需要使用内存分析工具(如MAT)分析Heap Dump文件。

- 数据库连接池耗尽:应用代码获取数据库连接后,在某些分支路径下忘记释放,导致连接被占满。

通过这一系列“定义-设计-执行-分析”的闭环实践,性能测试才能真正成为保障OA系统稳定性的“压舱石”。

五、面向未来的接口测试:引入Mock与服务虚拟化

在现代企业IT架构向微服务演进的浪潮中,OA系统不再是一个庞大的单体应用,而是由众多相互协作的微服务构成。日程服务可能需要调用用户中心服务获取参与者信息,调用通知服务发送提醒,调用会议室资源服务进行预定。这种复杂的依赖关系给测试带来了新的挑战:任何一个下游服务的不可用或不稳定,都会阻塞日程接口的测试工作。

为了解决这一痛点,引入Mock(模拟)与服务虚拟化技术,成为面向未来的必然选择。其核心思想是,为被测接口所依赖的下游服务创建一个“替身”(Mock Server)。这个替身能够模拟真实服务的行为,根据预设的规则返回指定的响应数据。

引入Mock与服务虚拟化的核心价值在于:

- 解除依赖,实现并行测试:当前端团队或日程服务团队需要进行测试时,不再需要等待用户中心、通知服务等所有下游服务都开发完成并部署到测试环境。他们可以针对Mock Server进行开发和测试,极大地提高了开发和测试的并行度,缩短了交付周期。

- 构建稳定、可控的测试环境:测试环境中的下游服务可能因为正在开发、存在缺陷或网络问题而频繁宕机。Mock Server则完全由测试团队控制,可以7x24小时提供稳定服务,确保测试过程不会被意外中断。

- 轻松模拟异常场景:在真实环境中模拟下游服务超时、返回500错误或返回特定业务错误码(如“用户不存在”、“会议室已被预定”)非常困难。而使用Mock Server,只需简单配置一条规则,就能精确模拟这些异常场景,从而对被测接口的容错处理逻辑进行充分验证。

- 降低测试环境成本:为每一个微服务都搭建一套完整的、包含所有依赖的测试环境,成本高昂。通过服务虚拟化,可以用轻量级的Mock Server替代重量级的真实服务,显著降低硬件和维护成本。

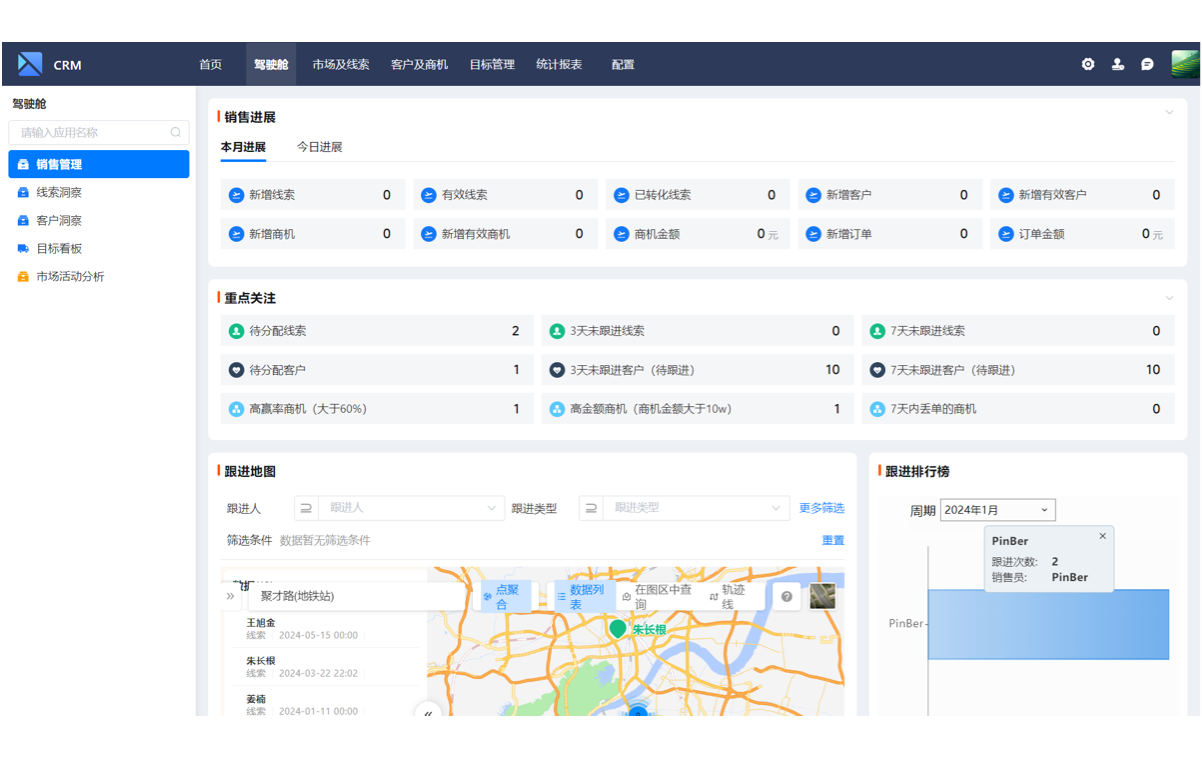

正如支道平台这类现代无代码/低代码平台通过其强大的API对接和规则引擎能力,简化了系统间的集成与数据流转,测试思维也应向更“解耦”、更“敏捷”的方向发展。通过服务虚拟化等技术,构建灵活、按需定制的测试环境,正是企业在数字化转型过程中,追求“效率提升”与“拥抱变革”的内在要求。它使得测试不再是流程的末端瓶颈,而是贯穿于整个开发生命周期的、敏捷的质量保障活动。

总结:构建可持续优化的OA日程接口测试体系

综上所述,高效优化OA日程接口测试,绝非一次性的技术攻坚,而是一项需要战略规划和持续投入的系统工程。它始于对复杂业务场景的深刻理解,立足于一套分层且全面的测试用例体系。在此基础上,通过引入自动化测试框架和数据驱动策略,将测试团队从繁琐的重复劳动中解放出来,实现效率的倍增。而专业的性能测试实践,则如同压舱石,确保系统在汹涌的业务洪峰中依然稳定可靠。最后,面向未来的微服务架构,拥抱Mock与服务虚拟化技术,更是实现测试敏捷化、解耦化的关键一步。

我们必须认识到,高效的日程接口测试,其价值远超发现几个技术缺陷。它直接关系到企业核心协同流程的顺畅度,影响着每一位员工的工作效率,最终保障了整体运营效率和决策执行力。这是一个持续迭代、不断优化的过程,需要将自动化测试、性能监控和先进的测试技术有机结合,构建一个既健壮又面向未来的质量保障体系。作为企业决策者,应当高度重视测试在数字化转型中的战略价值,它不仅是成本中心,更是驱动业务稳定增长、提升核心竞争力的价值创造中心。

若您希望构建一个从业务流程到系统集成均高度灵活、易于维护与测试的数字化平台,欢迎了解支道平台,体验新一代应用搭建方式。立即访问官网或免费试用。

关于OA接口测试的常见问题 (FAQ)

1. 如何测试涉及第三方日历(如钉钉、企业微信)同步的接口?

测试这类接口的关键在于“契约测试”和“端到端测试”的结合。首先,应基于第三方平台的API文档,使用Mock Server模拟其行为(成功、失败、超时),对己方系统的调用逻辑和异常处理进行充分测试。其次,在集成测试环境中,进行小范围的端到端真人测试,验证实际同步流程是否通畅,数据格式是否完全兼容。对于关键场景,可编写自动化脚本定期巡检,监控同步接口的健康状况。

2. 在敏捷开发模式下,如何快速回归OA接口?

核心是建立一套高价值的自动化回归测试集。这个测试集不追求100%覆盖,而是聚焦于核心业务流程(P0/P1级用例),如创建日程、查询日程、修改日程等。将其集成到CI/CD(持续集成/持续部署)流水线中,做到每次代码提交后自动触发。这样,任何破坏核心功能的代码变更都能在数分钟内被发现,实现快速反馈和修复。

3. 接口测试自动化脚本的维护成本很高,有什么好的建议吗?

降低维护成本的关键在于良好的设计。第一,采用数据驱动,将测试数据与测试逻辑分离。第二,对公共操作(如登录获取Token、数据清理)进行封装,实现代码复用。第三,遵循清晰的命名规范和代码结构,编写可读性高的脚本。第四,选择合适的工具,如使用REST Assured这类基于代码的框架,可以利用软件工程的最佳实践来管理测试代码,从而降低长期维护成本。

4. 对于存量的、没有接口文档的旧OA系统,应该如何开展接口测试?

这是一个挑战,但可以分步进行。首先,使用抓包工具(如Fiddler, Charles)捕获前端与后端交互的HTTP请求,通过分析实际请求的URL、方法、请求头和请求体,“逆向工程”出接口的基本协议。然后,基于这些抓取到的信息,编写初步的测试用例进行探索性测试。逐步完善对接口功能、参数和返回值的理解,并在此过程中补齐缺失的接口文档,最终将其纳入常规的自动化测试体系。