如何高效地进行研发流程节点考核,是许多管理者案头的难题。当被问及“如何评估一位工程师的技术贡献?”或“怎样衡量一个看起来很忙,但产出并不明确的员工?”时,多数管理者往往会陷入“凭感觉”的困境。

我们必须明确一个前提:高效的研发流程节点考核,其本质是建立一套数据驱动的“反馈系统”,而不是一套冰冷的“评分系统”。它的真正目标,是持续发现流程瓶颈、驱动团队优化,最终提升整体的研发效能,而非简单地对个人进行排名和评判。

告别效能“玄学”:研发考核为何总让你头疼?

在深入探讨解决方案之前,我们首先需要结构化地分析,为什么研发考核这件事总是如此棘手。基于我们服务超过 5000 家企业的经验,问题通常集中在以下四个方面。

痛点一:创造性工作难以量化

研发活动的核心是脑力劳动,其成果并不能像生产线上的零件一样被简单计数。过去,一些团队尝试使用代码行数(Lines of Code)作为衡量指标,但这很快被证明存在严重误导性。优秀的工程师可能会用更少的代码实现更优雅的解决方案,而为了堆砌指标,团队也可能写出大量冗余、低质的代码。

痛点二:考核标准难以统一

一个研发团队内包含前端、后端、测试、运维等多种角色,他们的工作性质和产出形式截然不同。用同一把标尺去衡量不同角色的贡献,例如,将后端工程师的接口吞吐量与测试工程师发现的缺陷数量直接对比,显然是不公平且不科学的。

痛点三:考核容易引发团队抵触

一旦考核方式设计不当,很容易从“评估”滑向“监控”。当工程师感觉到自己的一举一动都被监视,并且这些数据将直接用于负面评判时,他们的士气会受到严重打击。更糟糕的是,这会催生“指标导向”行为——团队成员不再关注创造真实的用户价值,而是想方设法“刷”高对自己有利的指标。

痛点四:数据采集困难且滞后

即便确定了考核指标,数据的采集和统计也往往是一项艰巨的任务。依赖管理者手动从项目管理工具、代码仓库等多个系统中导出数据,再用电子表格进行汇总分析,不仅耗费大量时间,而且数据严重滞后。当你看到上个月的数据时,问题可能早已演变,失去了最佳的干预时机。

理念重塑:好的考核是“反馈系统”,而非“评分系统”

要解决上述难题,首先需要的是一场理念上的变革。我们必须将考核的定位从“评分”转向“反馈”,其核心在于遵循以下三大原则。

核心原则一:对事不对人

在度量时,应优先关注团队和流程层面的宏观指标,而非过度聚焦于个人指标。例如,我们应该关心的是“团队的需求交付周期为什么变长了?”,而不是“为什么张三这个月的代码提交次数比李四少?”。通过数据发现的是系统性问题,目标是优化协作流程,而不是追究某个人的责任。

核心原则二:关注趋势而非绝对值

任何一个孤立时间点的数据都只是一个快照,参考价值有限。真正具有诊断价值的,是数据在连续时间周期内的变化趋势。一个团队的缺陷修复时长从平均 3 天下降到 1.5 天,这个下降的趋势远比“本月修复时长是 1.5 天”这个单一数值更有意义,它反映了团队在质量响应能力上的进步。

核心原则三:目标是“优化”而非“排名”

考核数据的最终归宿,应该是团队的复盘会议和流程改进计划,而不是员工的绩效排名表。将数据作为客观的输入,引导团队进行深入讨论,识别瓶颈,并共同制定改进方案,从而形成一个发现问题、分析问题、解决问题的管理闭环。

四步搭建数据驱动的研发流程节点考核框架

在正确的理念指导下,我们可以通过一个四步框架,系统性地搭建起一套有效的考核体系。

第一步:识别核心流程节点,定义“价值链”

首先,需要将从需求想法产生到最终交付给用户的完整过程进行解构,梳理出其中最关键的流程节点。这构成了一条清晰的“价值创造链”。

- 核心节点一:需求阶段

- 关键活动:需求评审、技术澄清、故事点评估与任务拆分。

- 核心节点二:开发阶段

- 关键活动:编码实现、代码审查(Code Review)、单元测试编写。

- 核心节点三:测试阶段

- 关键活动:功能测试、集成测试、缺陷提交与修复验证。

- 核心节点四:发布与运维阶段

- 关键活动:构建与部署上线、线上服务监控、生产故障响应。

通过这种方式,我们将一个复杂且连续的研发过程,拆解为了几个标准、可观测的关键检查点。

第二步:为关键节点匹配“体检”指标,而非“KPI”指标

为每个节点选择合适的度量指标,就像为身体的不同部位选择合适的体检项目。这些指标应该是反映流程健康度的“信号灯”,而不是压在团队头上的“KPI”。

- 需求阶段核心指标

- 需求吞吐量:衡量团队在单位时间内(如一个迭代或一个月)完成并交付的需求数量,反映了团队的价值交付速率。

- 需求交付周期(Lead Time):从需求被正式提出到最终成功上线的总时长,是端到端衡量交付效率的黄金指标。

- 开发阶段核心指标

- 开发周期(Cycle Time):从工程师开始处理一个需求到开发完成(提测)的时长,用于诊断开发环节的内部效率。

- 代码质量:可以通过代码评审覆盖率、静态代码扫描问题数、千行代码评论数等一系列代码质量相关指标进行综合衡量。

- 合并请求(PR)前置时间:从创建开发分支到发起第一个合并请求的时长,可以反映任务拆分是否合理,以及工程师启动工作的速度。

- 测试阶段核心指标

- 线上缺陷率 / 缺陷密度:衡量最终交付产品质量的关键。通常以“单位时间内线上新增缺陷数”或“每个需求平均缺陷数”来度量。

- 缺陷平均修复时长(MTTR):从发现一个线上缺陷到完成修复并上线的平均时间,直接反映团队响应和解决问题的效率。

- 发布与运维阶段核心指标

- 发布频率:团队向生产环境部署代码的频率。高发布频率是敏捷开发和 DevOps 成熟度的核心标志,体现了团队持续交付和快速响应市场变化的能力。

- 变更失败率:部署到生产环境后,导致服务降级或需要修正的百分比。这个指标衡量了发布过程的稳定性和风险控制能力。

每个节点都有其专属的“听诊器”,通过这些精心选择的度量指标,我们可以精确地诊断整个研发流程的健康状况。

第三步:建立自动化数据通路,让数据“说话”

理念和指标都已具备,但要让体系真正运转起来,必须解决数据获取的问题。

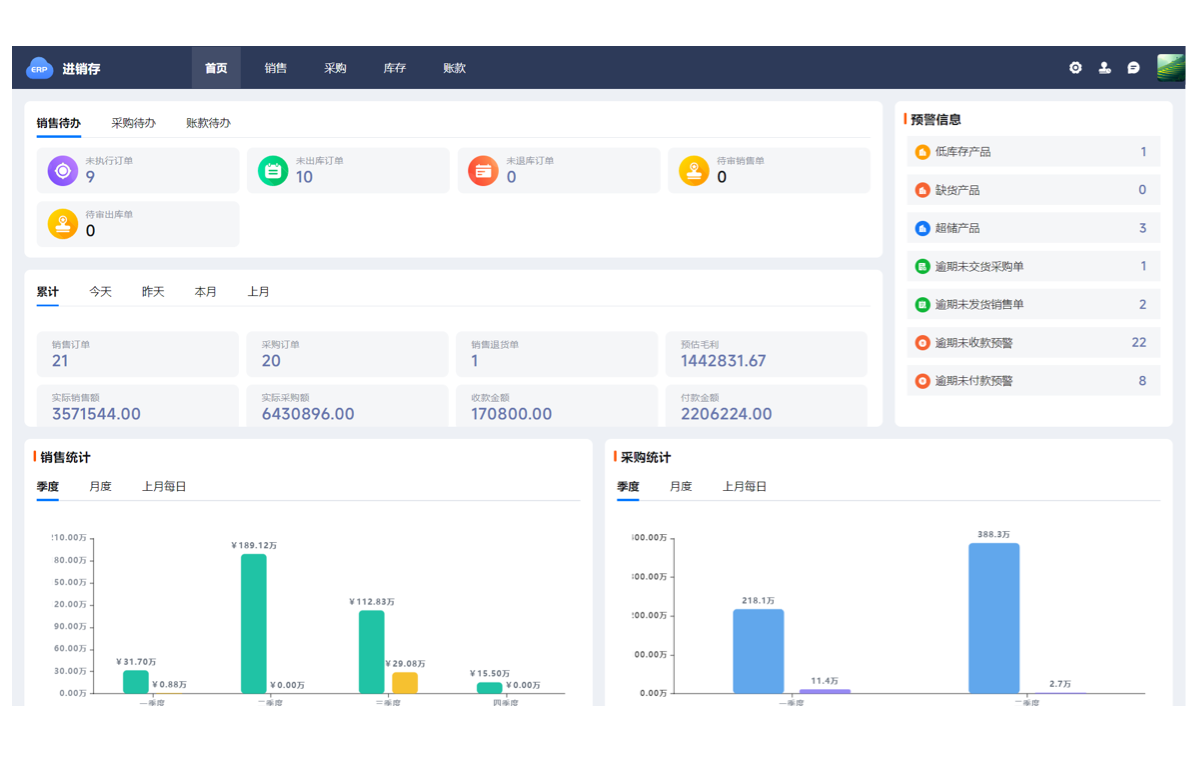

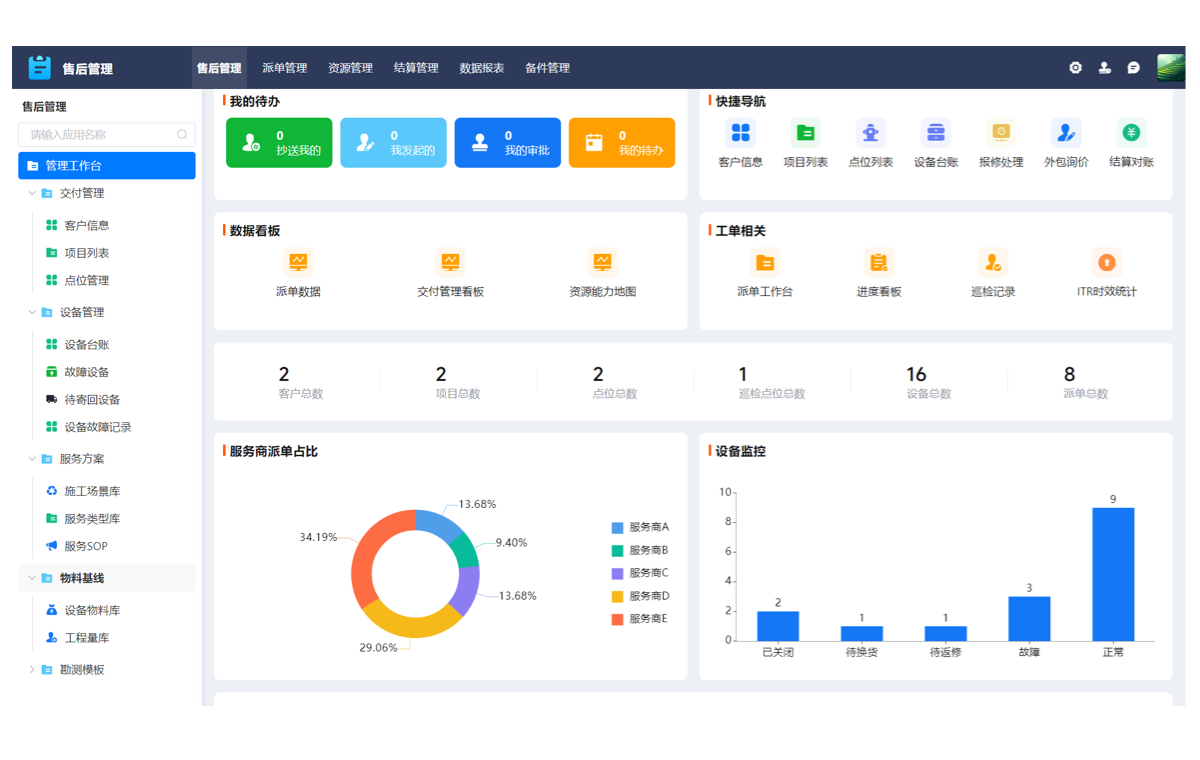

- 数据源整合要实现高效考核,数据采集必须是自动化的。这意味着需要打通研发工具链,直接从项目管理工具(如 Jira、ONES)、代码托管平台(如 GitLab、GitHub)等源头系统自动拉取数据。

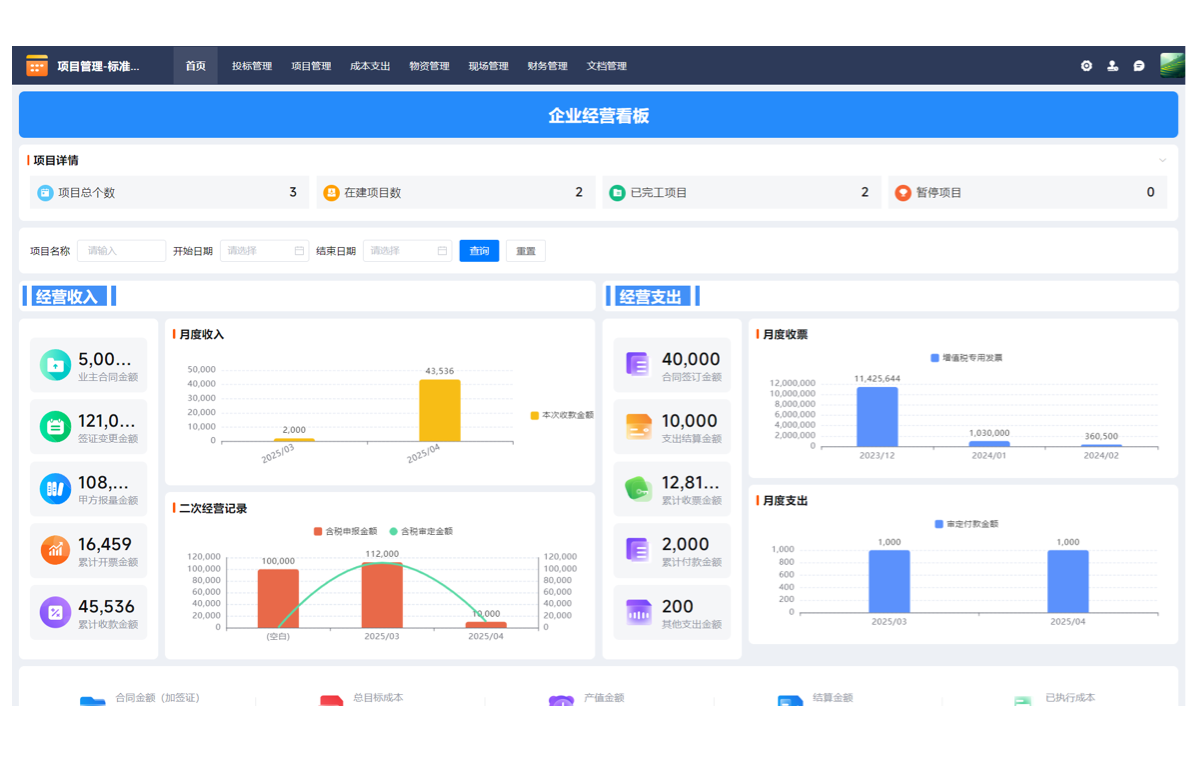

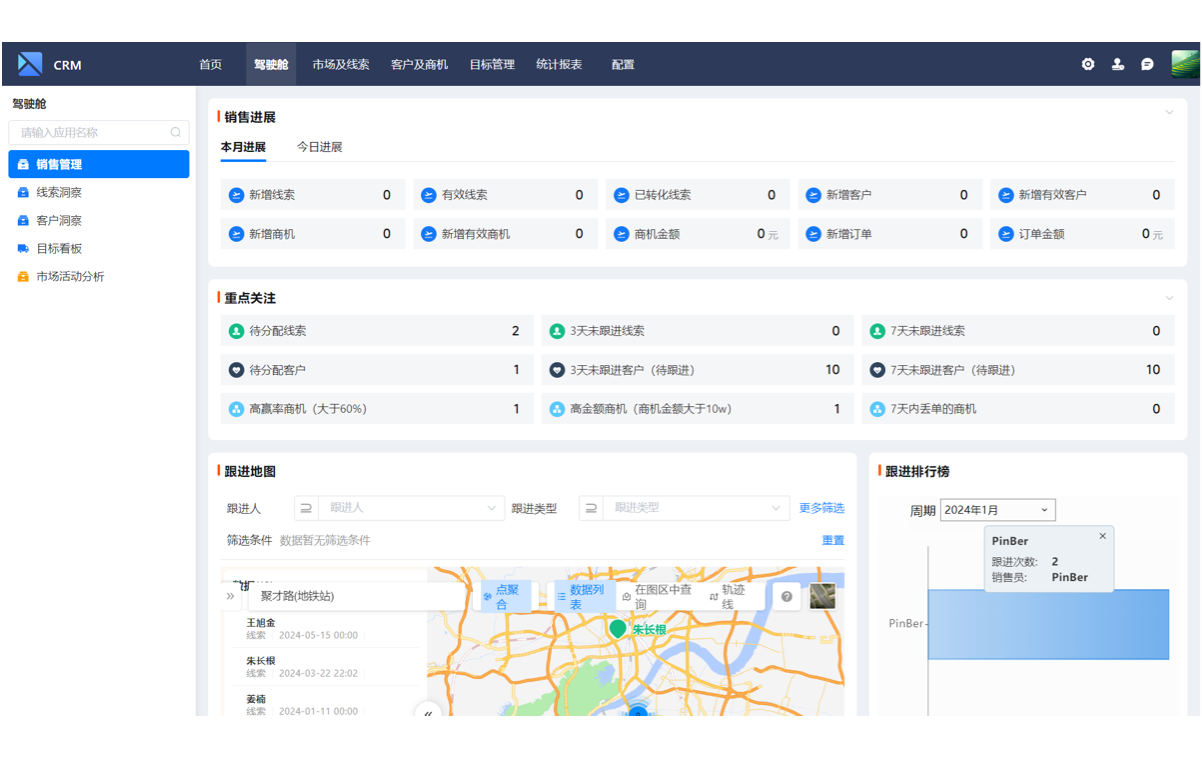

- 数据清洗与可视化原始数据往往是杂乱的,需要进行清洗和关联,然后通过可视化的方式呈现。建立一个统一的研发效能度量看板,将关键指标以趋势图、分布图等直观形式展现出来,是让数据变得易于理解的关键。

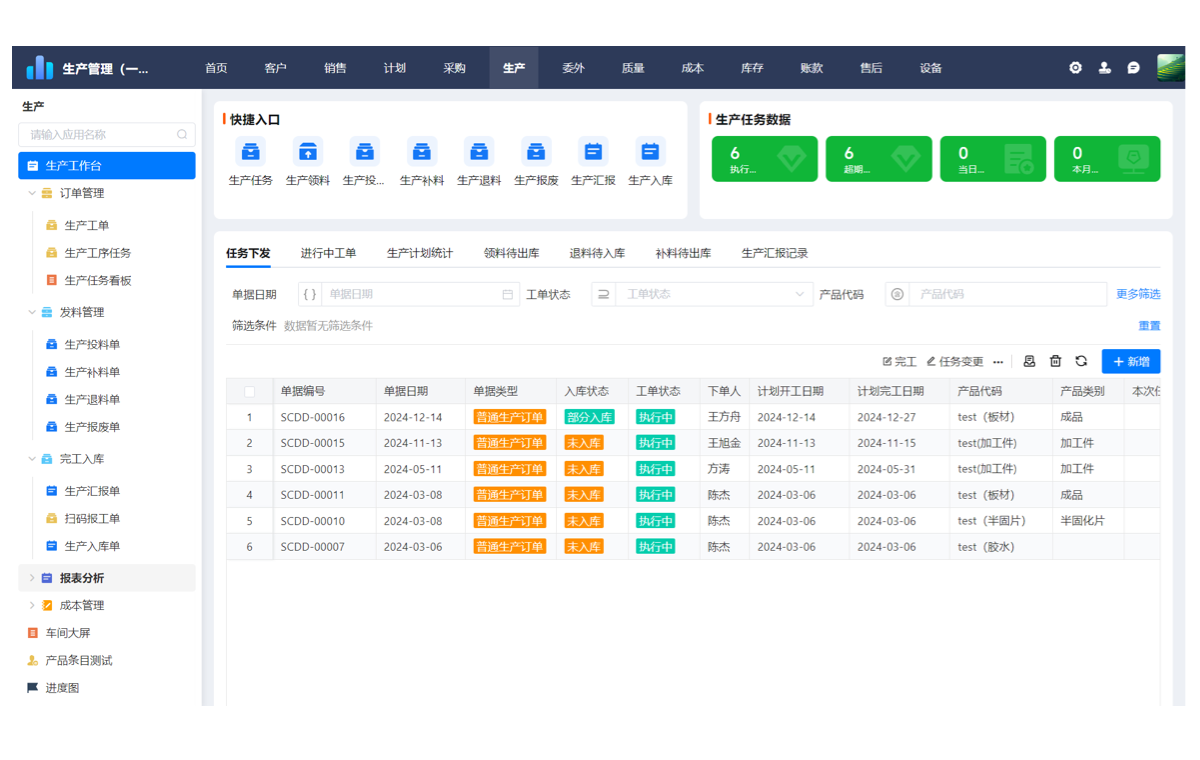

- 工具化提效在实践中,企业可以通过 [支道] 这类专业的研发管理工具,来系统性地解决数据问题。这类工具预置了行业标准的度量模型,能够自动采集和整合来自不同工具的数据,并生成多维度的洞察报表,将管理者从繁琐的数据统计工作中彻底解放出来。

打通数据孤岛,让数据获取接近零成本,是整个考核体系能够持续、低成本运行的绝对前提。

第四步:从团队复盘开始,持续应用与迭代

数据本身不产生任何价值,只有当它被用于驱动沟通和改进时,价值才会显现。

- 定期召开数据复盘会以固定的节奏(如每两周或每月),团队管理者应基于数据看板,与全体成员共同进行复盘。会议的焦点不是追责,而是客观地分析数据趋势,识别出流程中的潜在瓶颈或异常波动。

- 制定可执行的改进计划(Action Item)对于复盘中发现的问题,不能止步于讨论。必须共同制定出具体、可执行的改进措施,并明确责任人(Owner)和完成时限(Due Date)。

- 小步快跑,持续迭代不要试图一蹴而就地建立一个完美的考核体系。正确的做法是,先从解决 1-2 个核心痛点出发,选择最关键的几个指标,跑通“数据采集-分析复盘-制定计划-执行改进”这个数据驱动的闭环。当团队习惯了这种工作方式后,再逐步引入更多的度量维度。

数据不会说话,但基于数据展开的有效沟通和持续改进,将为团队带来真正的价值。

实践避坑指南:三个最容易走错的路口

在推行数据驱动的考核体系时,有几个常见的误区需要极力避免。

误区一:将指标直接与个人绩效挂钩

这是最危险也是最常见的错误。一旦将流程性指标(如发布频率、交付周期)直接作为个人绩效的考核依据,必然会导致前文提到的“刷指标”行为。正确的做法是,考核结果主要用于团队激励和流程改进,个人绩效应结合技术贡献、协作表现、业务影响力等多方面进行综合评估,避免“唯指标论”。

误区二:追求大而全的指标体系

一些管理者试图从一开始就建立一个包含几十个指标的“完美”体系,但这往往会因为过于复杂而难以落地。团队成员会被海量的数据淹没,抓不住重点。正确的做法是,初期聚焦 3-5 个与当前团队核心痛点最相关的指标,集中精力进行改进,待体系和文化成熟后,再按需逐步扩展。

误区三:忽略与团队的沟通和共识

任何管理变革,如果缺乏透明的沟通和团队的共识,都注定会失败。在推行之前,管理者必须向团队清晰地阐述这套体系的目的、方法和基本原则,反复强调其目标是帮助团队变得更好,而不是为了“监控”或“找茬”,从而争取到团队的理解和支持。

总结:让考核回归提升效能的本质

总而言之,一套高效的研发流程节点考核管理体系,本质上是一个持续的反馈和优化系统。

要搭建这个系统,我们提供了一个清晰可行的四步框架:识别节点 → 匹配指标 → 打通数据 → 应用迭代。这条路径的核心,是摒弃传统的、自上而下的“评分”思维,转向一种数据驱动、团队参与的“反馈”模式。

最终的目标始终如一:通过客观的数据洞察,引导团队持续改进其研发流程和工程实践,最终实现研发效能和交付质量的稳步、可持续提升。

获取完整的研发效能度量方案

想了解超过 30 个开箱即用的研发效能度量指标及其应用场景吗?下载《研发效能度量白皮书》,立即构建属于你的数据驱动反馈系统。[CTA 按钮:免费下载白皮书]