一次成功的版本发布,是以“上线完成”为终点,还是以“价值验证”为起点?在服务超过5000家企业的过程中,我们发现一个普遍的管理盲区:许多研发团队投入巨大精力进行功能开发与系统变更,但发布之后,其真实效果却成了一笔糊涂账。好与不好,往往依赖项目经理的“感觉”或是少数用户的零星反馈。要走出这种困境,建立一套结构化的研发变更执行效果评估流程至关重要。本文将提供一套可落地的四步评估闭环方法,帮助企业告别模糊判断。

为什么要建立一套标准化的研发变更效果评估流程?

在数字化竞争日益激烈的今天,将工程资源精确投向能产生最大价值的领域,是企业保持领先的关键。一套标准化的评估流程,其价值远不止于“了解上线效果”,它至少能带来三个层面的核心收益:

- 实现从“任务交付”到“价值交付”的思维转变:它驱动团队的关注点从“我们做了什么功能”转向“我们解决了什么问题,创造了多少价值”,这是建立高绩效研发文化的第一步。

- 为技术决策和业务优化提供客观的数据依据:无论是决定继续投入优化一个功能,还是快速叫停一个失败的尝试,都需要可信的数据作为决策基础,而非依赖个人权威或主观臆断。

- 驱动团队进行有效复盘,实现持续改进:清晰的评估结论能够让团队准确识别成功经验和失败教训,将每一次变更都转化为组织能力的沉淀,避免重复犯错。

高效评估第一步:明确目标,定义“成功”标准

在启动任何评估之前,必须首先对“成功”进行清晰、无歧义的定义。如果连目的地都不知道在哪里,那么无论走哪个方向都是错的。

设定评估目标:你想通过本次变更解决什么核心问题?

评估目标必须与变更的初衷紧密相连。例如,一次“优化注册流程”的变更,其核心目标可能是“提升新用户注册转化率”,而不是“让页面加载更快”。目标设定必须具体、可衡量,且直指业务或技术痛点。

关键指标选取:如何将评估目标进行量化?

将抽象的目标转化为具体的衡量指标,是评估能否落地的关键。通常,我们可以从以下三个维度选择和组合指标:

- 业务指标 (Business Metrics)

- 用户转化率 / 核心功能使用率

- 用户活跃度 (DAU/MAU) / 用户留存率

- 业务订单量 / GMV

- 技术指标 (Technical Metrics)

- 系统性能(平均响应时间、TP99)

- 系统稳定性(错误率、崩溃率)

- 资源消耗(CPU、内存使用率)

- 质量与效率指标 (Quality & Efficiency Metrics)

- 线上缺陷数量 / 严重等级

- 需求或缺陷修复周期

专家提示:避免陷入“指标越多越好”的常见误区

选择1-3个最能直接反映变更核心目标的“北极星指标”即可。过多的指标会分散注意力,甚至出现指标间相互矛盾的情况,导致评估结论模糊不清。

本步小结:没有明确的衡量标准,就没有有效的评估。

高效评估第二步:多维采集,获取真实可信的数据

定义好指标后,下一步就是通过可靠的渠道获取真实、完整的数据。数据的质量直接决定了评估结论的可信度。

核心数据收集渠道与方法

- 线上监控系统:这是获取技术性能与稳定性数据的首选,例如 Prometheus、Zabbix 或云厂商提供的监控服务。

- 用户行为分析工具:通过 Google Analytics、Amplitude 等工具,可以精准追踪用户转化、留存等业务指标的变化。

- A/B 测试平台:对于面向用户的重大功能变更,A/B 测试是剥离干扰因素、验证变更与效果之间因果关系的最严谨方法。

- 用户反馈渠道:通过问卷、用户访谈、客服工单等方式,收集定性的用户声音,这对于理解数据波动背后的原因至关重要。

确定数据收集周期:评估应该持续多久?

评估周期并非越长越好。应根据业务特性和用户行为周期来确定。对于高频交易应用,可能一两天就能看到显著变化;而对于低频使用的企业软件,则可能需要一到两个月的数据才能得出稳定结论。

常见误区:只看“变更后”数据,忽视“变更前”基线对比

任何评估都必须建立在一个稳定的基线(Baseline)之上。如果缺少变更前的数据作为参照,变更后的数据将毫无意义,无法判断是“变好了”还是“变差了”。

本步小结:数据的真实性和完整性是评估结论可信度的基石。

高效评估第三步:综合分析,洞察数据背后的因果关系

收集到数据只是第一步,更核心的工作是从数据中洞察出“变更行为”与“效果结果”之间的真实联系。

数据对比分析:找到变化的参照系

- 基线对比:将变更后一个周期内的数据与变更前同一周期的数据进行纵向比较,这是最基础的分析方法。

- 同期群对比 (Cohort Analysis):将变更后引入的新用户群体与变更前的老用户群体进行分组对比,观察他们在关键行为上的差异。

关联性分析:判断指标变化是否由本次变更引起

数据变化了,但一定是这次变更导致的吗?分析时需要排除其他可能。例如,用户活跃度提升,究竟是新功能上线带来的,还是因为同期市场部门投放了一轮大规模广告?这就是为什么 A/B 测试如此重要,它能最大程度地保证控制变量的唯一性。

定性与定量结合:用用户反馈解释数据波动

定量数据告诉我们“发生了什么”,而定性反馈则能帮助我们理解“为什么会发生”。如果发现新版功能的转化率下降了,可以调阅同期的用户反馈,看看是否有大量用户抱怨新流程操作不便。

专家提示:警惕“伪关系”,识别其他可能的影响因素

在进行分析时,务必将其他潜在的影响因素纳入考量,例如季节性波动、市场活动、竞争对手动态、甚至是节假日效应。将这些因素排除或量化其影响,才能得到更准确的结论。

本步小结:分析的核心是建立“变更行为”与“效果结果”之间的可信链接。

高效评估第四步:结论输出,将评估转化为行动

评估的最终目的是为了指导未来的行动。一份束之高阁的评估报告没有任何价值,只有将结论转化为团队共识和具体行动,评估才算真正完成了闭环。

撰写一份清晰的评估报告

一份有效的评估报告,应该像一份给决策者的“商业计划书”,清晰、简洁且结论明确。

- 评估报告的核心构成要素

- 变更背景与目标回顾:一句话说明我们当初为什么要做这个变更,以及期望达到什么目标。

- 核心指标表现(数据与图表):用最直观的图表展示核心指标在变更前后的数据对比。

- 综合分析与核心结论:基于数据,明确给出本次变更“成功”、“失败”或“效果不显著”的结论,并阐述关键原因。

- 经验总结与后续行动建议(Action Items):总结本次变更中的经验教训,并提出明确的下一步行动计划,例如“继续优化”、“回滚功能”或“投入更多资源”。

结论可视化:如何让你的报告更具说服力?

相比于密密麻麻的数字表格,一张清晰的趋势图或对比柱状图,更能让管理者在30秒内抓住核心信息。善用数据可视化工具,能让你的评估结论更具冲击力和说服力。

组织变更回顾会:将评估结论转化为团队共识和改进动力

组织相关干系人(产品、研发、测试、运维等)召开一次简短的变更回顾会。在会上同步评估报告,对齐认知,并就后续行动计划达成共识。这不仅是传递信息,更是塑造数据驱动文化的重要仪式。

本步小结:一份好的评估报告不仅是总结,更是未来优化的起点。

[支道]实践:将评估流程自动化与产品化

对于追求卓越工程效能的团队而言,手动的、项目制的评估方式效率低下且难以规模化。我们的观察显示,头部企业正在积极将评估流程自动化与产品化。

-

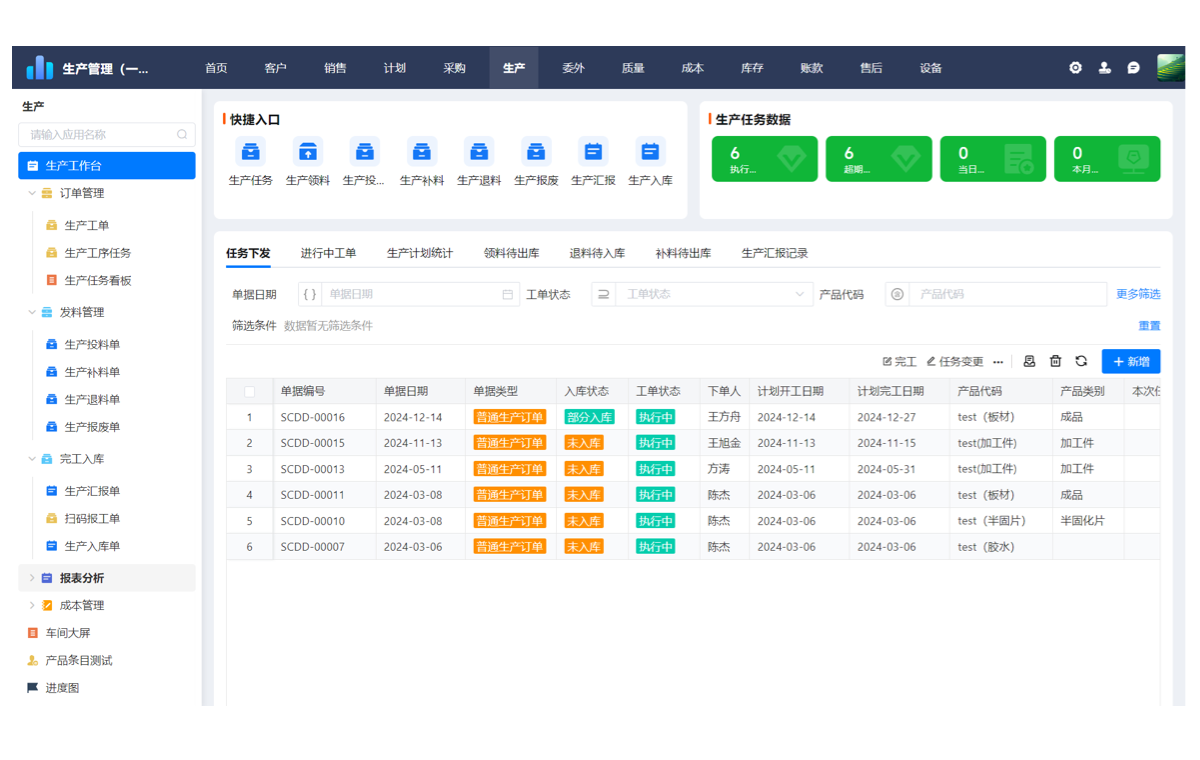

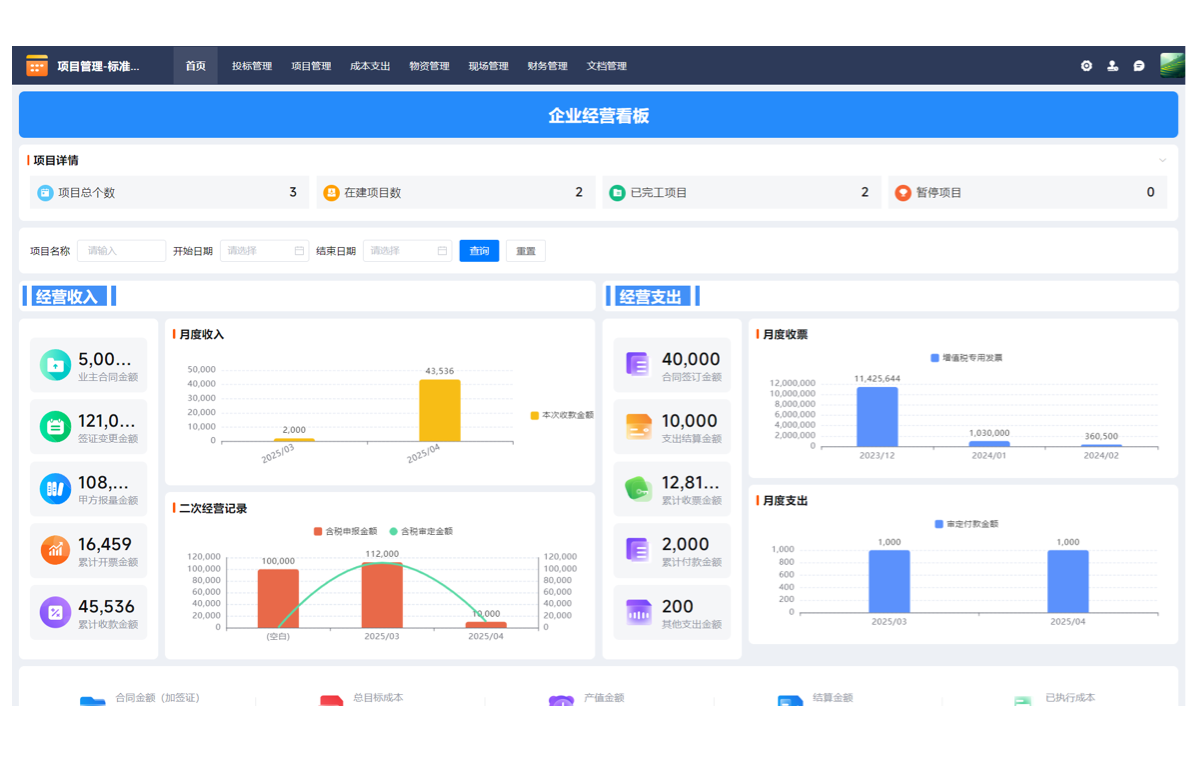

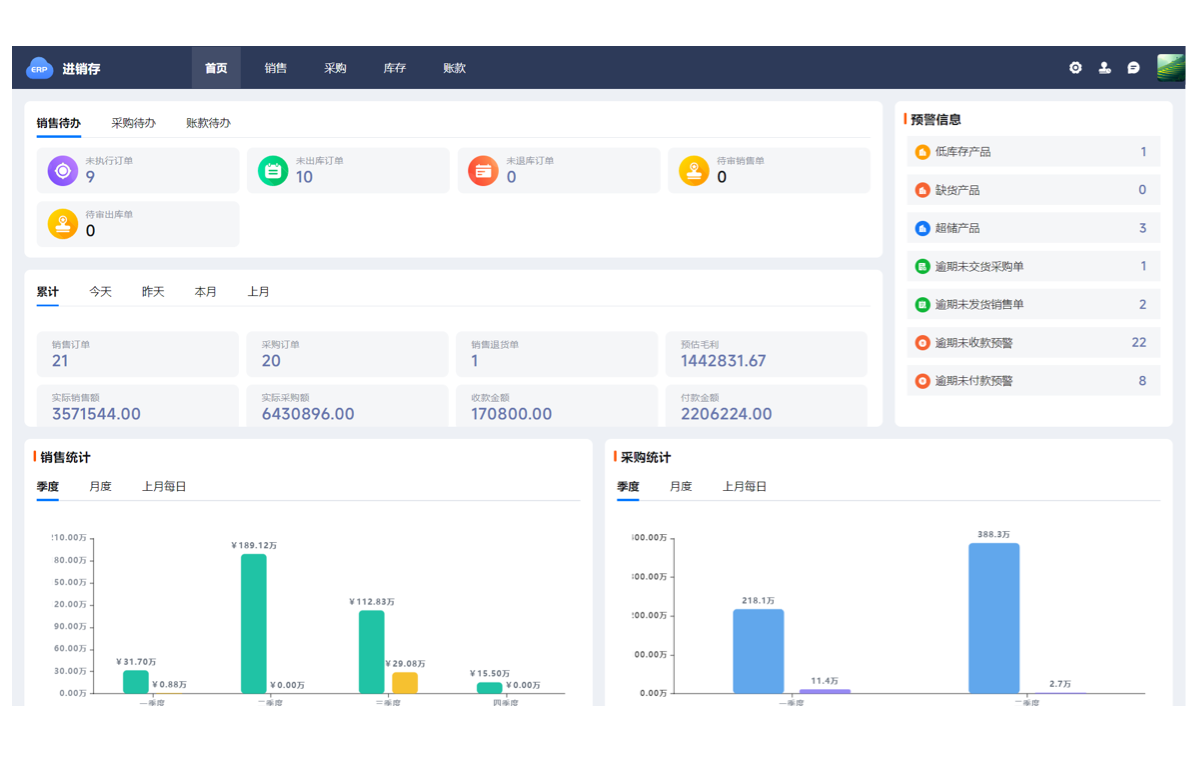

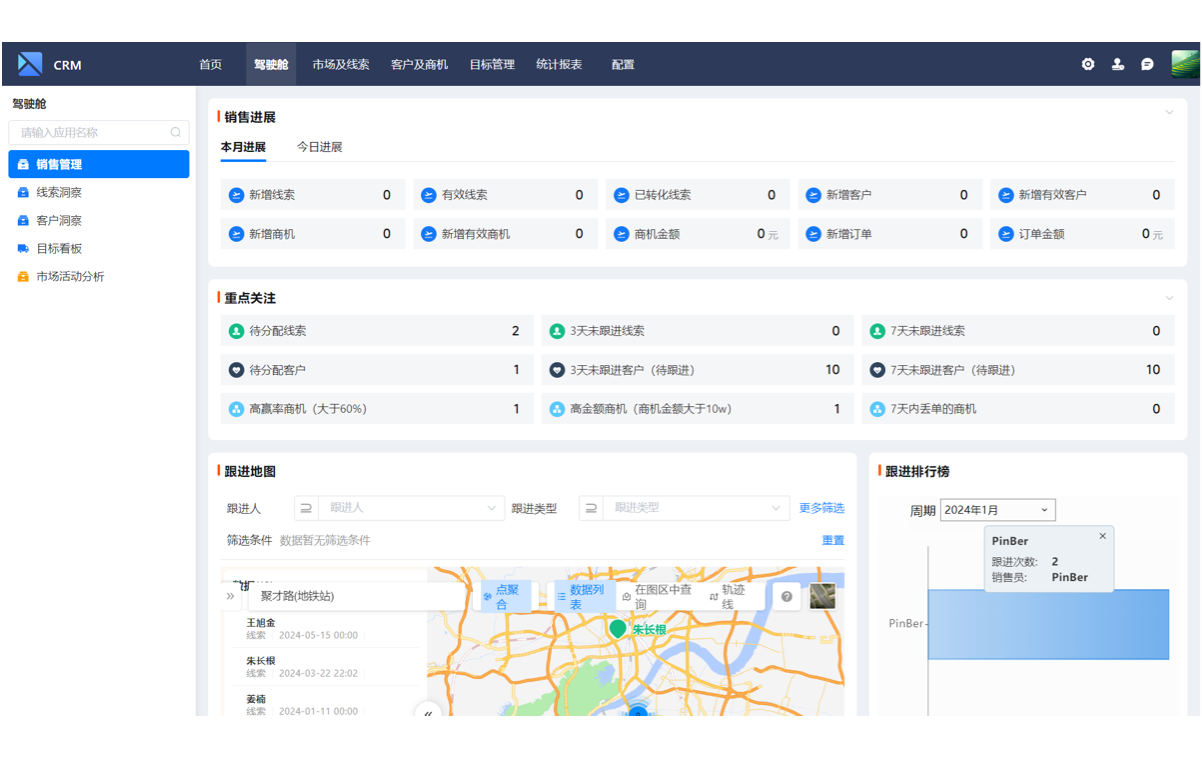

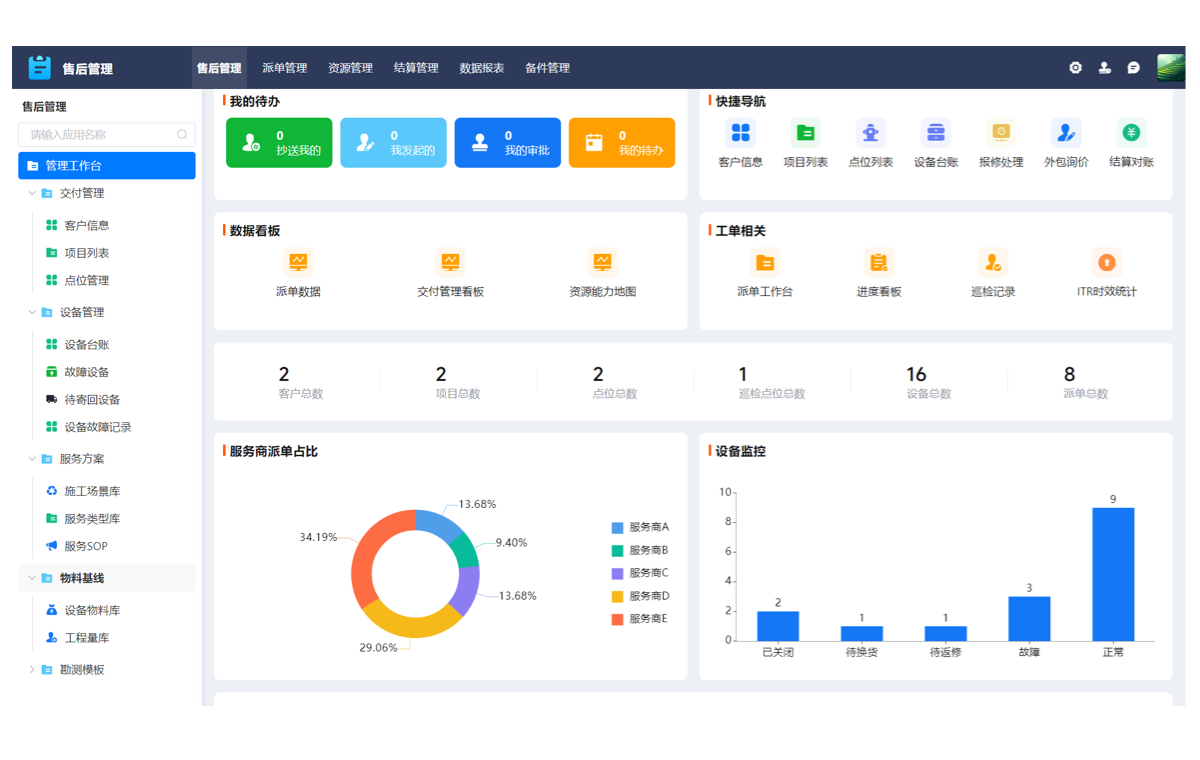

场景示例:通过自动化看板实时追踪变更后的核心指标将与变更相关的核心业务、技术指标聚合到一个自动更新的监控看板中。发布后,团队可以实时、直观地看到变更带来的影响,从而实现快速响应。

-

场景示例:构建可复用的评估模型与报告模板,提升评估效率将成熟的评估流程固化为产品内的标准模板。每次发起评估时,只需关联相应的变更单和核心指标,系统即可自动拉取数据、生成标准化报告初稿,将评估分析师从重复的数据整理工作中解放出来。

获取更完整的研发效能评估指标体系

一套行之有效的评估流程,离不开科学的指标体系作为支撑。我们已将服务头部企业的实践经验与行业洞察,沉淀为一份详尽的白皮书。欢迎下载《研发变更效果评估白皮书》,深入了解不同业务场景下的评估实践与指标库。

总结:让每一次变更都成为一次有价值的学习

回归本源,研发变更执行效果评估的核心,是建立一个持续学习和改进的反馈闭环。通过“明确目标、收集数据、综合分析、结论输出”这四个步骤,我们可以确保每一次研发投入都有据可循、有果可溯。

这不仅仅是一种技术管理方法,更是一种思维模式的升级——从关注“完成功能”,真正转向关注“为客户和业务创造价值”。只有这样,研发才能成为驱动企业增长的真正引擎,而非被动的成本中心。